2021

08-08

08-08

Pytorch反向传播中的细节-计算梯度时的默认累加操作

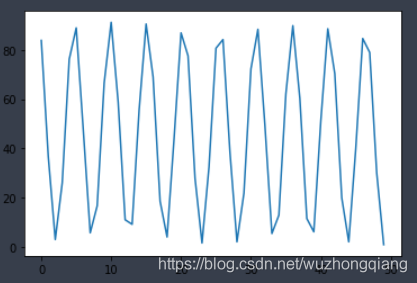

Pytorch反向传播计算梯度默认累加今天学习pytorch实现简单的线性回归,发现了pytorch的反向传播时计算梯度采用的累加机制,于是百度来一下,好多博客都说了累加机制,但是好多都没有说明这个累加机制到底会有啥影响,所以我趁着自己练习的一个例子正好直观的看一下以及如何解决:pytorch实现线性回归先附上试验代码来感受一下:torch.manual_seed(6)lr=0.01#学习率result=[]#创建训练数据x=torch.rand(20,1)*10y=...

继续阅读 >

Pytorch反向传播计算梯度默认累加今天学习pytorch实现简单的线性回归,发现了pytorch的反向传播时计算梯度采用的累加机制,于是百度来一下,好多博客都说了累加机制,但是好多都没有说明这个累加机制到底会有啥影响,所以我趁着自己练习的一个例子正好直观的看一下以及如何解决:pytorch实现线性回归先附上试验代码来感受一下:torch.manual_seed(6)lr=0.01#学习率result=[]#创建训练数据x=torch.rand(20,1)*10y=...

继续阅读 >

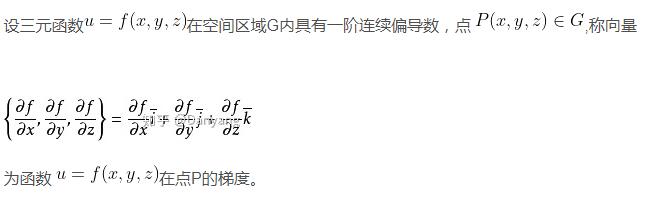

在PyTorch中,torch.Tensor类是存储和变换数据的重要工具,相比于Numpy,Tensor提供GPU计算和自动求梯度等更多功能,在深度学习中,我们经常需要对函数求梯度(gradient)。PyTorch提供的autograd包能够根据输入和前向传播过程自动构建计算图,并执行反向传播。本篇将介绍和总结如何使用autograd包来进行自动求梯度的有关操作。1.概念Tensor是这个pytorch的自动求导部分的核心类,如果将其属性.requires_grad=True,它将开始追踪(...

在PyTorch中,torch.Tensor类是存储和变换数据的重要工具,相比于Numpy,Tensor提供GPU计算和自动求梯度等更多功能,在深度学习中,我们经常需要对函数求梯度(gradient)。PyTorch提供的autograd包能够根据输入和前向传播过程自动构建计算图,并执行反向传播。本篇将介绍和总结如何使用autograd包来进行自动求梯度的有关操作。1.概念Tensor是这个pytorch的自动求导部分的核心类,如果将其属性.requires_grad=True,它将开始追踪(...

一、禁止计算局部梯度torch.autogard.no_grad:禁用梯度计算的上下文管理器。当确定不会调用Tensor.backward()计算梯度时,设置禁止计算梯度会减少内存消耗。如果需要计算梯度设置Tensor.requires_grad=True两种禁用方法:将不用计算梯度的变量放在withtorch.no_grad()里>>>x=torch.tensor([1.],requires_grad=True)>>>withtorch.no_grad():...y=x*2>>>y.requires_gradOut[12]:False使用装饰器@torch.no_gard()修...

一、禁止计算局部梯度torch.autogard.no_grad:禁用梯度计算的上下文管理器。当确定不会调用Tensor.backward()计算梯度时,设置禁止计算梯度会减少内存消耗。如果需要计算梯度设置Tensor.requires_grad=True两种禁用方法:将不用计算梯度的变量放在withtorch.no_grad()里>>>x=torch.tensor([1.],requires_grad=True)>>>withtorch.no_grad():...y=x*2>>>y.requires_gradOut[12]:False使用装饰器@torch.no_gard()修...