2021

03-05

03-05

pytorch 实现L2和L1正则化regularization的操作

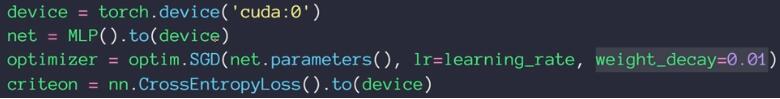

1.torch.optim优化器实现L2正则化torch.optim集成了很多优化器,如SGD,Adadelta,Adam,Adagrad,RMSprop等,这些优化器自带的一个参数weight_decay,用于指定权值衰减率,相当于L2正则化中的λ参数,注意torch.optim集成的优化器只有L2正则化方法,你可以查看注释,参数weight_decay的解析是:weight_decay(float,optional):weightdecay(L2penalty)(default:0)使用torch.optim的优化器,可如下设置L2正则化optimizer=...

继续阅读 >

1.torch.optim优化器实现L2正则化torch.optim集成了很多优化器,如SGD,Adadelta,Adam,Adagrad,RMSprop等,这些优化器自带的一个参数weight_decay,用于指定权值衰减率,相当于L2正则化中的λ参数,注意torch.optim集成的优化器只有L2正则化方法,你可以查看注释,参数weight_decay的解析是:weight_decay(float,optional):weightdecay(L2penalty)(default:0)使用torch.optim的优化器,可如下设置L2正则化optimizer=...

继续阅读 >