2020

10-08

10-08

Pytorch实现将模型的所有参数的梯度清0

有两种方式直接把模型的参数梯度设成0:model.zero_grad()optimizer.zero_grad()#当optimizer=optim.Optimizer(model.parameters())时,两者等效如果想要把某一Variable的梯度置为0,只需用以下语句:Variable.grad.data.zero_()补充知识:PyTorch中在反向传播前为什么要手动将梯度清零?optimizer.zero_grad()的意义optimizer.zero_grad()意思是把梯度置零,也就是把loss关于weight的导数变成0.在学习pytorch的时候注意到,对于每...

继续阅读 >

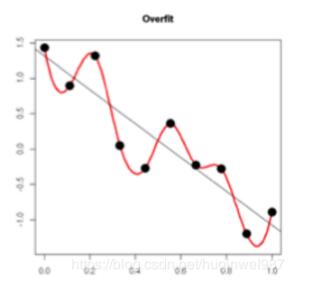

L2正则化原理:过拟合的原理:在loss下降,进行拟合的过程中(斜线),不同的batch数据样本造成红色曲线的波动大,图中低点也就是过拟合,得到的红线点低于真实的黑线,也就是泛化更差。可见,要想减小过拟合,减小这个波动,减少w的数值就能办到。L2正则化训练的原理:在Loss中加入(乘以系数λ的)参数w的平方和,这样训练过程中就会抑制w的值,w的(绝对)值小,模型复杂度低,曲线平滑,过拟合程度低(奥卡姆剃刀),参考公式...

L2正则化原理:过拟合的原理:在loss下降,进行拟合的过程中(斜线),不同的batch数据样本造成红色曲线的波动大,图中低点也就是过拟合,得到的红线点低于真实的黑线,也就是泛化更差。可见,要想减小过拟合,减小这个波动,减少w的数值就能办到。L2正则化训练的原理:在Loss中加入(乘以系数λ的)参数w的平方和,这样训练过程中就会抑制w的值,w的(绝对)值小,模型复杂度低,曲线平滑,过拟合程度低(奥卡姆剃刀),参考公式...