2021

03-09

03-09

Python jieba 中文分词与词频统计的操作

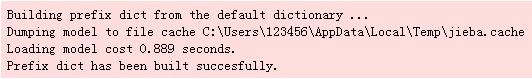

我就废话不多说了,大家还是直接看代码吧~#!python3#-*-coding:utf-8-*-importos,codecsimportjiebafromcollectionsimportCounterdefget_words(txt):seg_list=jieba.cut(txt)c=Counter()forxinseg_list:iflen(x)>1andx!='\r\n':c[x]+=1print('常用词频度统计结果')for(k,v)inc.most_common(100):print('%s%s%s%d'%(''*(5-len(k)),k,'*'*int(v/3),v))if__name__=='__main__'...

继续阅读 >

我就废话不多说了,大家还是直接看代码吧~#!python3#-*-coding:utf-8-*-importos,codecsimportjiebafromcollectionsimportCounterdefget_words(txt):seg_list=jieba.cut(txt)c=Counter()forxinseg_list:iflen(x)>1andx!='\r\n':c[x]+=1print('常用词频度统计结果')for(k,v)inc.most_common(100):print('%s%s%s%d'%(''*(5-len(k)),k,'*'*int(v/3),v))if__name__=='__main__'...

继续阅读 >

摘要:一般来说的全文搜索服务,大体是基于字和关键词的,基于语句的全文搜索服务是一个有意思的课题。以文字为最小节点,以语句为分枝,建立语义树,提供基于语义树的全文检索服务。通过对语句进行语义特征编码,并结合数据库,来实现基于语义树的全文索引和搜索服务。1引言搜索引擎是信息时代的基础服务之一,搜索引擎服务的核心为全文检索。常用的全文检索,一般以关键词的检索为主,对于不同的语言需要不同的...

摘要:一般来说的全文搜索服务,大体是基于字和关键词的,基于语句的全文搜索服务是一个有意思的课题。以文字为最小节点,以语句为分枝,建立语义树,提供基于语义树的全文检索服务。通过对语句进行语义特征编码,并结合数据库,来实现基于语义树的全文索引和搜索服务。1引言搜索引擎是信息时代的基础服务之一,搜索引擎服务的核心为全文检索。常用的全文检索,一般以关键词的检索为主,对于不同的语言需要不同的...

Linux环境为:CentOS5.5、Ubuntu12.041、软件下载sphinx-2.1.3coreseek-4.12、安装sphinxtarzxvfsphinx-2.1.3.tar.gz//解压sphinx包cdsphinx-2.1.3./configure--prefix=/usr/local/sphinx--with-mysql=/usr/local/mysql/--prefix:指定sphinx的安装路径--with-mysql:指定mysql安装路径sudomake&&makeinstall编译并安装安装成功之后,sphinx会形成三个命令:indexer创建索引命令searchd启动进程命令s...

Linux环境为:CentOS5.5、Ubuntu12.041、软件下载sphinx-2.1.3coreseek-4.12、安装sphinxtarzxvfsphinx-2.1.3.tar.gz//解压sphinx包cdsphinx-2.1.3./configure--prefix=/usr/local/sphinx--with-mysql=/usr/local/mysql/--prefix:指定sphinx的安装路径--with-mysql:指定mysql安装路径sudomake&&makeinstall编译并安装安装成功之后,sphinx会形成三个命令:indexer创建索引命令searchd启动进程命令s...