当我们使用python的hdfs包进行上传和下载文件的时候,总会出现如下问题

requests.packages.urllib3.exceptions.NewConnectionError:<requests.packages.urllib3.connection.HTTPConnection object at 0x7fe87cc37c50>: Failed to establish a new connection: [Errno -2] Name or service not known

其实这主要是由于没有将各个集群节点的ip映射到/etc/hosts文件中

修改/etc/hosts文件,将各个集群节点ip映射加上即可,如博主所示

vim /etc/hosts

192.168.20.174 hadoop04

192.168.20.173 hadoop03

192.168.20.172 hadoop02

192.168.20.171 hadoop01

补充知识:python上传文件到hadoop异常问题

使用库:pyhdfs

调用方法:

pyhdfs.HdfsClient(ip,port,user).copy_from_local()

pyhdfs.HdfsClient(ip,port,user).copy_to_local()

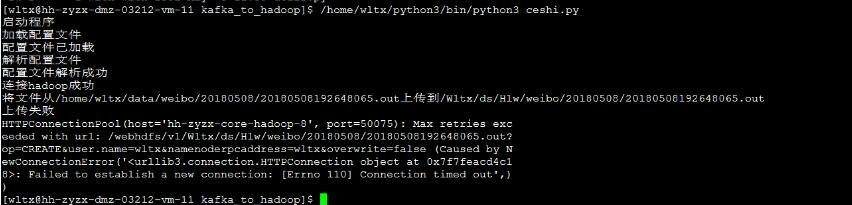

异常现象1如下图:

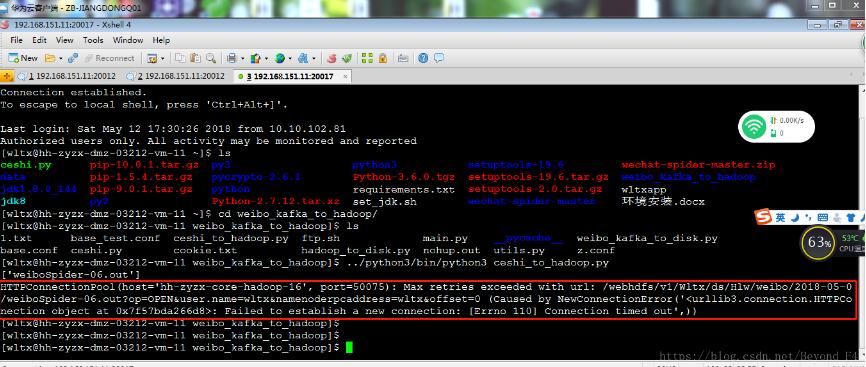

异常现象2如下图:

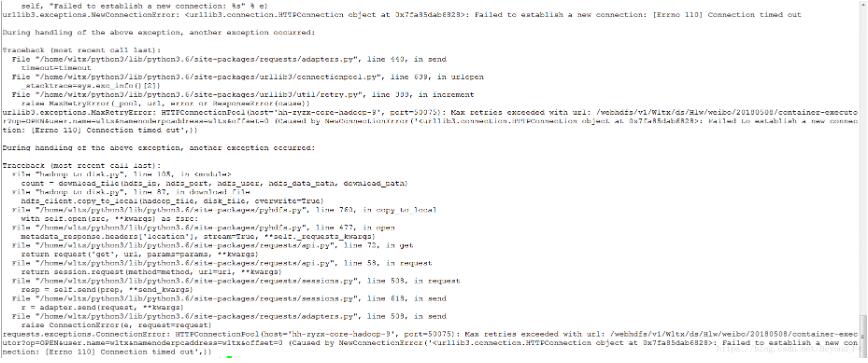

异常现象3如下图:

原因分析:可以看出,以上都是连接成功了,但是上传或者下载失败了,造成这种现象的原因是

我这里连接的是name节点,端口50070,当调用copy_from_local()时,name节点会主动去连接data节点进行数据读写操作,而data节点端口50075没有开启,造成data节点连接超时,抛出异常

解决办法:开启data节点端口

以上这篇完美解决python针对hdfs上传和下载的问题就是小编分享给大家的全部内容了,希望能给大家一个参考,也希望大家多多支持自学编程网。

- 本文固定链接: https://zxbcw.cn/post/188156/

- 转载请注明:必须在正文中标注并保留原文链接

- QQ群: PHP高手阵营官方总群(344148542)

- QQ群: Yii2.0开发(304864863)