总的来说,R的运算速度不算快,不过类似并行运算之类的改进可以提高运算的性能。下面非常简要地介绍如何利用R语言进行并行运算

library(parallel) cl.cores <- detectCores() cl <- makeCluster(cl.cores)

detectCores( )检查当前电脑可用核数。

makeCluster(cl.cores)使用刚才检测的核并行运算。R-Doc里这样描述makeCluster函数:Creates a set of copies of R running in parallel and communicating over sockets. 即同时创建数个R进行并行运算。

在该函数执行后就已经开始并行运算了,电脑可能会变卡一点。尤其在执行par开头的函数时。

在并行运算环境下,常用的一些计算方法如下:

1. clusterEvalQ(cl,expr)函数利用创建的cl执行expr

这里利用刚才创建的cl核并行运算expr。expr是执行命令的语句,不过如果命令太长的话,一般写到文件里比较好。比如把想执行的命令放在Rcode.r里:

clusterEvalQ(cl,source(file="Rcode.r"))

2.par开头的apply函数族

这族函数和apply的用法基本一样,不过要多加一个参数cl。一般如果cl创建如上面cl <- makeCluster(cl.cores)的话,这个参数可以直接用作parApply(cl=cl,…)。

当然Apply也可以是Sapply,Lapply等等。注意par后面的第一个字母是要大写的,而一般的apply函数族第一个字母不大写。另外要注意,即使构建了并行运算的核,不使用parApply()函数,而使用apply()函数的话,则仍然没有实现并行运算。

换句话说,makeCluster只是创建了待用的核,而不是并行运算的环境。

最后,终止并行运算只需要一行命令

stopCluster(cl)

案例1

不使用并行计算,直接使用lapply(隐式循环函数,它实际就是对不同的数据应用了相同的函数):

fun <- function(x){

return (x+1);

}

system.time({

res <- lapply(1:5000000, fun);

});

user system elapsed

21.42 1.74 25.70

案例2

使用parallel包来加速

library(parallel)

#打开四核,具体核数根据机器的核数决定

cl <- makeCluster(getOption("cl.cores", 4));

system.time({

res <- parLapply(cl, 1:5000000, fun)

});

user system elapsed

6.54 0.34 19.95

#关闭并行计算

stopCluster(cl);

看看单核机器跑出来的结果:

user system elapsed 29.30 9.23 97.22

所以,并非核数越多越好,看机器配置。

这个函数有两点要注意:

首先要先用detectCores函数确定系统核心数目,对于Window系统下的Intel I5或I7 处理器,一般使用detectCores(logical = F)来获得实际的物理核心数量。

由于这个函数使用的是调用Rscript的方式,这个例子里,对象被复制了三份,因此内存会吃的很厉害,在大数据条件就要小心使用。

案例3

在Linux下使用mclapply函数的效果如下:

mc <- getOption("mc.cores", 3)

system.time({

res <- mclapply(1:5000000, fun, mc.cores = mc);

});

user system elapsed

6.657 0.500 7.181

stopCluster(cl);

补充:R语言如何并行处理[parallel package][向量化操作并行优化]

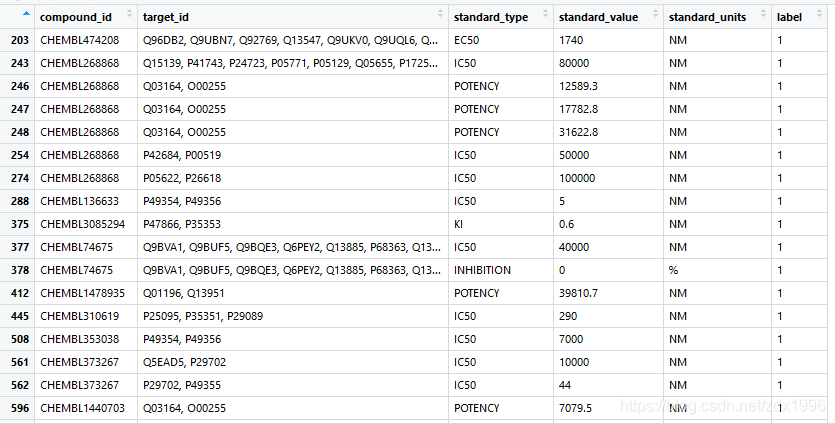

使用数据,长下面这样:

方法:

使用parallel包,并行向量化处理,进一步提升原先向量化处理速度。

原始代码:

start <- Sys.time() experiment_step1 <- apply(dtc_small_modify, 1, decompose) end <- Sys.time() print(end-start)

原始运行时间:3.083114 分

使用parallel包后

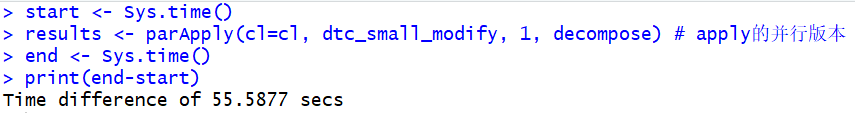

library(parallel) #并行处理包 cl.cores <- detectCores(logical = F) #计算电脑核心数 cl <- makeCluster(cl.cores) # 初始化要使用的核心数 start <- Sys.time() results <- parApply(cl=cl, dtc_small_modify, 1, decompose) # apply的并行版本 stopCluster(cl) # 关闭并行模式 end <- Sys.time() print(end-start)

并行后

运行时间:55.5877 秒,相较原先,速度提升了将近四倍!

Tips:上述是对向量化(Vectorization)apply类的并行处理。对于apply的并行处理,必须使用par开头的对应apply.

列表如下:

parLapply(cl = NULL, X, fun, …, chunk.size = NULL)

parSapply(cl = NULL, X, FUN, …, simplify = TRUE, USE.NAMES = TRUE, chunk.size = NULL)

parApply(cl = NULL, X, MARGIN, FUN, …, chunk.size = NULL)

parRapply(cl = NULL, x, FUN, …, chunk.size = NULL)

parCapply(cl = NULL, x, FUN, …, chunk.size = NULL)

parLapplyLB(cl = NULL, X, fun, …, chunk.size = NULL)

parSapplyLB(cl = NULL, X, FUN, …, simplify = TRUE, USE.NAMES = TRUE, chunk.size = NULL)

使用apply类向量化操作后,常常产生大规模列表,可能需要将列表转成一个完整的大数据框。

以上为个人经验,希望能给大家一个参考,也希望大家多多支持自学编程网。如有错误或未考虑完全的地方,望不吝赐教。

- 本文固定链接: https://zxbcw.cn/post/210262/

- 转载请注明:必须在正文中标注并保留原文链接

- QQ群: PHP高手阵营官方总群(344148542)

- QQ群: Yii2.0开发(304864863)