2021

04-27

04-27

简述python四种分词工具,盘点哪个更好用?

大家好,我是安果!分词在自然语言处理中有着常见的场景,比如从一篇文章自动提取关键词就需要用到分词工具,中文搜索领域同样离不开分词Python中有很多开源的分词工具,下面给大家介绍几款常见的分词依赖库1.jieba分词“结巴”分词,GitHub最受欢迎的分词工具,立志做最好的Python中文分词组件,支持多种分词模式,支持自定义词典githubstar:26k代码示例import jiebastrs=["我来到北京清华大学","乒乓球拍卖完了","...

继续阅读 >

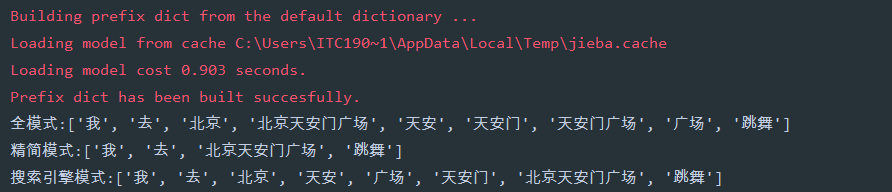

1、简要说明结巴分词支持三种分词模式,支持繁体字,支持自定义词典2、三种分词模式全模式:把句子中所有的可以成词的词语都扫描出来,速度非常快,但是不能解决歧义精简模式:把句子最精确的分开,不会添加多余单词,看起来就像是把句子分割一下搜索引擎模式:在精简模式下,对长词再度切分#-*-encoding=utf-8-*-importjiebaif__name__=='__main__':str1='我去北京天安门广场跳舞'a=jieba.lcut(str1,cut_all=True...

1、简要说明结巴分词支持三种分词模式,支持繁体字,支持自定义词典2、三种分词模式全模式:把句子中所有的可以成词的词语都扫描出来,速度非常快,但是不能解决歧义精简模式:把句子最精确的分开,不会添加多余单词,看起来就像是把句子分割一下搜索引擎模式:在精简模式下,对长词再度切分#-*-encoding=utf-8-*-importjiebaif__name__=='__main__':str1='我去北京天安门广场跳舞'a=jieba.lcut(str1,cut_all=True...