2021

08-08

08-08

Pytorch反向传播中的细节-计算梯度时的默认累加操作

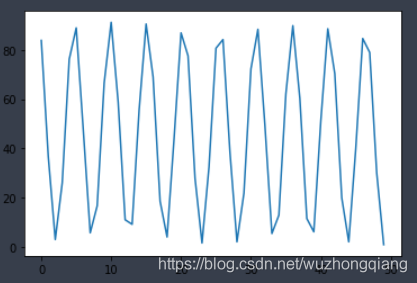

Pytorch反向传播计算梯度默认累加今天学习pytorch实现简单的线性回归,发现了pytorch的反向传播时计算梯度采用的累加机制,于是百度来一下,好多博客都说了累加机制,但是好多都没有说明这个累加机制到底会有啥影响,所以我趁着自己练习的一个例子正好直观的看一下以及如何解决:pytorch实现线性回归先附上试验代码来感受一下:torch.manual_seed(6)lr=0.01#学习率result=[]#创建训练数据x=torch.rand(20,1)*10y=...

继续阅读 >

Pytorch反向传播计算梯度默认累加今天学习pytorch实现简单的线性回归,发现了pytorch的反向传播时计算梯度采用的累加机制,于是百度来一下,好多博客都说了累加机制,但是好多都没有说明这个累加机制到底会有啥影响,所以我趁着自己练习的一个例子正好直观的看一下以及如何解决:pytorch实现线性回归先附上试验代码来感受一下:torch.manual_seed(6)lr=0.01#学习率result=[]#创建训练数据x=torch.rand(20,1)*10y=...

继续阅读 >

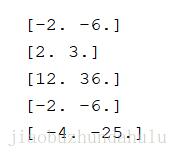

看代码吧~X=tf.constant([-1,-2],dtype=tf.float32)w=tf.Variable([2.,3.])truth=[3.,3.]Y=w*X#cost=tf.reduce_sum(tf.reduce_sum(Y*truth)/(tf.sqrt(tf.reduce_sum(tf.square(Y)))*tf.sqrt(tf.reduce_sum(tf.square(truth)))))cost=Y[1]*Yoptimizer=tf.train.GradientDescentOptimizer(1).minimize(cost)withtf.Session()assess:sess.run(tf.global_variables_initializer())print(sess.run(Y))print(sess.run(...

看代码吧~X=tf.constant([-1,-2],dtype=tf.float32)w=tf.Variable([2.,3.])truth=[3.,3.]Y=w*X#cost=tf.reduce_sum(tf.reduce_sum(Y*truth)/(tf.sqrt(tf.reduce_sum(tf.square(Y)))*tf.sqrt(tf.reduce_sum(tf.square(truth)))))cost=Y[1]*Yoptimizer=tf.train.GradientDescentOptimizer(1).minimize(cost)withtf.Session()assess:sess.run(tf.global_variables_initializer())print(sess.run(Y))print(sess.run(...

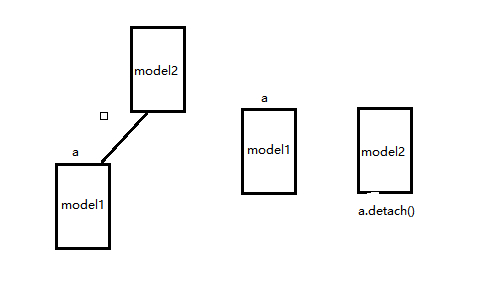

之前我的一篇文章pytorch计算图以及backward,讲了一些pytorch中基本的反向传播,理清了梯度是如何计算以及下降的,建议先看懂那个,然后再看这个。从一个错误说起:RuntimeError:Tryingtobackwardthroughthegraphasecondtime,butthebuffershavealreadybeenfreed在深度学习中,有些场景需要进行两次反向,比如Gan网络,需要对D进行一次,还要对G进行一次,很多人都会遇到上面这个错误,这个错误的意思就是尝试对...

之前我的一篇文章pytorch计算图以及backward,讲了一些pytorch中基本的反向传播,理清了梯度是如何计算以及下降的,建议先看懂那个,然后再看这个。从一个错误说起:RuntimeError:Tryingtobackwardthroughthegraphasecondtime,butthebuffershavealreadybeenfreed在深度学习中,有些场景需要进行两次反向,比如Gan网络,需要对D进行一次,还要对G进行一次,很多人都会遇到上面这个错误,这个错误的意思就是尝试对...

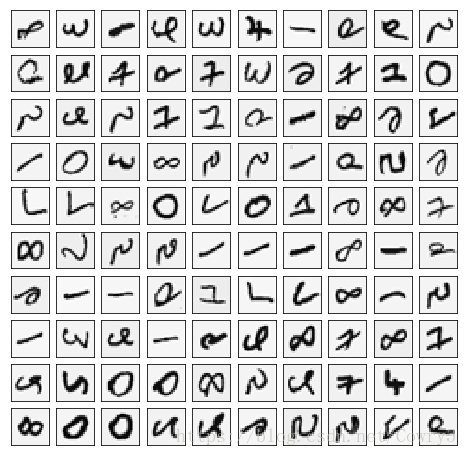

1NeuralNetworks神经网络1.1Visualizingthedata可视化数据这部分我们随机选取100个样本并可视化。训练集共有5000个训练样本,每个样本是20*20像素的数字的灰度图像。每个像素代表一个浮点数,表示该位置的灰度强度。20×20的像素网格被展开成一个400维的向量。在我们的数据矩阵X中,每一个样本都变成了一行,这给了我们一个5000×400矩阵X,每一行都是一个手写数字图像的训练样本。importnumpyasnpimportmatplotlib.pyp...

1NeuralNetworks神经网络1.1Visualizingthedata可视化数据这部分我们随机选取100个样本并可视化。训练集共有5000个训练样本,每个样本是20*20像素的数字的灰度图像。每个像素代表一个浮点数,表示该位置的灰度强度。20×20的像素网格被展开成一个400维的向量。在我们的数据矩阵X中,每一个样本都变成了一行,这给了我们一个5000×400矩阵X,每一行都是一个手写数字图像的训练样本。importnumpyasnpimportmatplotlib.pyp...

反向传播的目的是计算成本函数C对网络中任意w或b的偏导数。一旦我们有了这些偏导数,我们将通过一些常数α的乘积和该数量相对于成本函数的偏导数来更新网络中的权重和偏差。这是流行的梯度下降算法。而偏导数给出了最大上升的方向。因此,关于反向传播算法,我们继续查看下文。我们向相反的方向迈出了一小步——最大下降的方向,也就是将我们带到成本函数的局部最小值的方向。图示演示:反向传播算法中Sigmoid函数代码演示:#实现...

反向传播的目的是计算成本函数C对网络中任意w或b的偏导数。一旦我们有了这些偏导数,我们将通过一些常数α的乘积和该数量相对于成本函数的偏导数来更新网络中的权重和偏差。这是流行的梯度下降算法。而偏导数给出了最大上升的方向。因此,关于反向传播算法,我们继续查看下文。我们向相反的方向迈出了一小步——最大下降的方向,也就是将我们带到成本函数的局部最小值的方向。图示演示:反向传播算法中Sigmoid函数代码演示:#实现...