2021

06-22

06-22

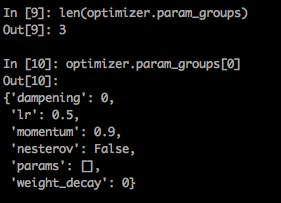

pytorch 优化器(optim)不同参数组,不同学习率设置的操作

optim的基本使用fordo:1.计算loss2.清空梯度3.反传梯度4.更新参数optim的完整流程cifiron=nn.MSELoss()optimiter=torch.optim.SGD(net.parameters(),lr=0.01,momentum=0.9)foriinrange(iters):out=net(inputs)loss=cifiron(out,label)optimiter.zero_grad()#清空之前保留的梯度信息loss.backward()#将mini_batch的loss信息反传回去optimiter.step()#根据optim参数和梯度更新参...

继续阅读 >

optim的基本使用fordo:1.计算loss2.清空梯度3.反传梯度4.更新参数optim的完整流程cifiron=nn.MSELoss()optimiter=torch.optim.SGD(net.parameters(),lr=0.01,momentum=0.9)foriinrange(iters):out=net(inputs)loss=cifiron(out,label)optimiter.zero_grad()#清空之前保留的梯度信息loss.backward()#将mini_batch的loss信息反传回去optimiter.step()#根据optim参数和梯度更新参...

继续阅读 >