2020

10-10

10-10

如何在scrapy中捕获并处理各种异常

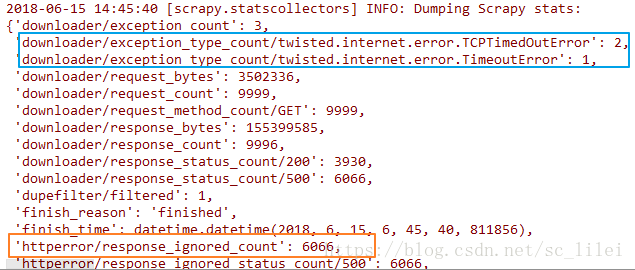

前言 使用scrapy进行大型爬取任务的时候(爬取耗时以天为单位),无论主机网速多好,爬完之后总会发现scrapy日志中“item_scraped_count”不等于预先的种子数量,总有一部分种子爬取失败,失败的类型可能有如下图两种(下图为scrapy爬取结束完成时的日志):scrapy中常见的异常包括但不限于:downloaderror(蓝色区域),httpcode403/500(橙色区域)。不管是哪种异常,我们都可以参考scrapy自带的retry中间件写法...

继续阅读 >

前言 使用scrapy进行大型爬取任务的时候(爬取耗时以天为单位),无论主机网速多好,爬完之后总会发现scrapy日志中“item_scraped_count”不等于预先的种子数量,总有一部分种子爬取失败,失败的类型可能有如下图两种(下图为scrapy爬取结束完成时的日志):scrapy中常见的异常包括但不限于:downloaderror(蓝色区域),httpcode403/500(橙色区域)。不管是哪种异常,我们都可以参考scrapy自带的retry中间件写法...

继续阅读 >