2021

08-08

08-08

pytorch自定义不可导激活函数的操作

pytorch自定义不可导激活函数今天自定义不可导函数的时候遇到了一个大坑。首先我需要自定义一个函数:sign_fimporttorchfromtorch.autogradimportFunctionimporttorch.nnasnnclasssign_f(Function):@staticmethoddefforward(ctx,inputs):output=inputs.new(inputs.size())output[inputs>=0.]=1output[inputs<0.]=-1ctx.save_for_backward(inputs)returnoutp...

继续阅读 >

pytorch自定义不可导激活函数今天自定义不可导函数的时候遇到了一个大坑。首先我需要自定义一个函数:sign_fimporttorchfromtorch.autogradimportFunctionimporttorch.nnasnnclasssign_f(Function):@staticmethoddefforward(ctx,inputs):output=inputs.new(inputs.size())output[inputs>=0.]=1output[inputs<0.]=-1ctx.save_for_backward(inputs)returnoutp...

继续阅读 >

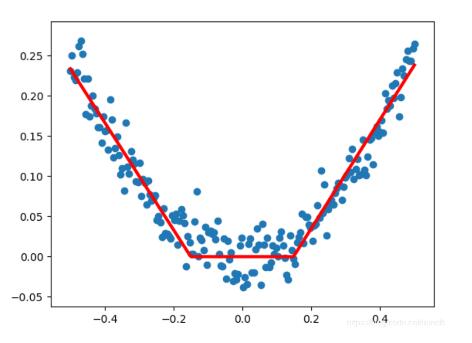

我就废话不多说了,大家还是直接看代码吧~importkerasimportnumpyasnpimportmatplotlib.pyplotasplt#Sequential按顺序构成的模型fromkeras.modelsimportSequential#Sequential是模型结构,输入层,隐藏层,输出层#Dense全连接层,Activation激活函数fromkeras.layersimportDense,Activationfromkeras.optimizersimportSGDx_data=np.linspace(-0.5,0.5,200)#从-0.5到0.5范围内生成200个随机点noise=np.random.nor...

我就废话不多说了,大家还是直接看代码吧~importkerasimportnumpyasnpimportmatplotlib.pyplotasplt#Sequential按顺序构成的模型fromkeras.modelsimportSequential#Sequential是模型结构,输入层,隐藏层,输出层#Dense全连接层,Activation激活函数fromkeras.layersimportDense,Activationfromkeras.optimizersimportSGDx_data=np.linspace(-0.5,0.5,200)#从-0.5到0.5范围内生成200个随机点noise=np.random.nor...

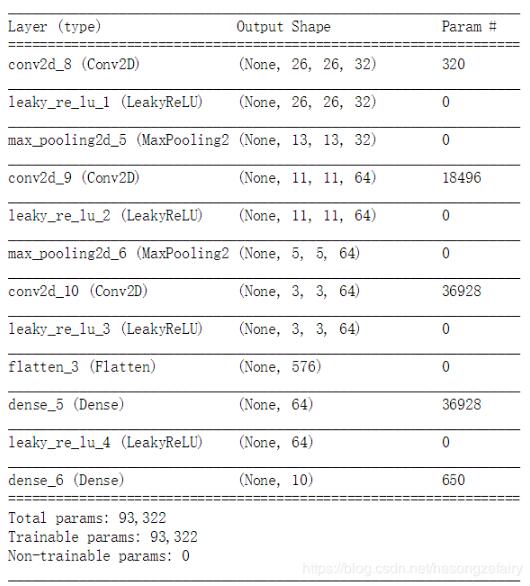

在用Keras来实现CNN等一系列网络时,我们经常用ReLU作为激活函数,一般写法如下:fromkerasimportlayersfromkerasimportmodelsmodel=models.Sequential()model.add(layers.Conv2D(32,(3,3),activation='relu',input_shape=(28,28,1)))model.add(layers.MaxPooling2D((2,2)))model.add(layers.Conv2D(64,(3,3),activation='relu'))model.add(layers.MaxPooling2D((2,2)))model.add(layers.Conv2D(64,(3,3),...

在用Keras来实现CNN等一系列网络时,我们经常用ReLU作为激活函数,一般写法如下:fromkerasimportlayersfromkerasimportmodelsmodel=models.Sequential()model.add(layers.Conv2D(32,(3,3),activation='relu',input_shape=(28,28,1)))model.add(layers.MaxPooling2D((2,2)))model.add(layers.Conv2D(64,(3,3),activation='relu'))model.add(layers.MaxPooling2D((2,2)))model.add(layers.Conv2D(64,(3,3),...