2021

07-01

07-01

基于BCEWithLogitsLoss样本不均衡的处理方案

最近在做deepfake检测任务(可以将其视为二分类问题,label为1和0),遇到了正负样本不均衡的问题,正样本数目是负样本的5倍,这样会导致FP率较高。尝试将正样本的loss权重增高,看BCEWithLogitsLoss的源码Examples::>>>target=torch.ones([10,64],dtype=torch.float32)#64classes,batchsize=10>>>output=torch.full([10,64],0.999)#Aprediction(logit)>>>pos_weight=torch.ones([64])#...

继续阅读 >

最近在做deepfake检测任务(可以将其视为二分类问题,label为1和0),遇到了正负样本不均衡的问题,正样本数目是负样本的5倍,这样会导致FP率较高。尝试将正样本的loss权重增高,看BCEWithLogitsLoss的源码Examples::>>>target=torch.ones([10,64],dtype=torch.float32)#64classes,batchsize=10>>>output=torch.full([10,64],0.999)#Aprediction(logit)>>>pos_weight=torch.ones([64])#...

继续阅读 >

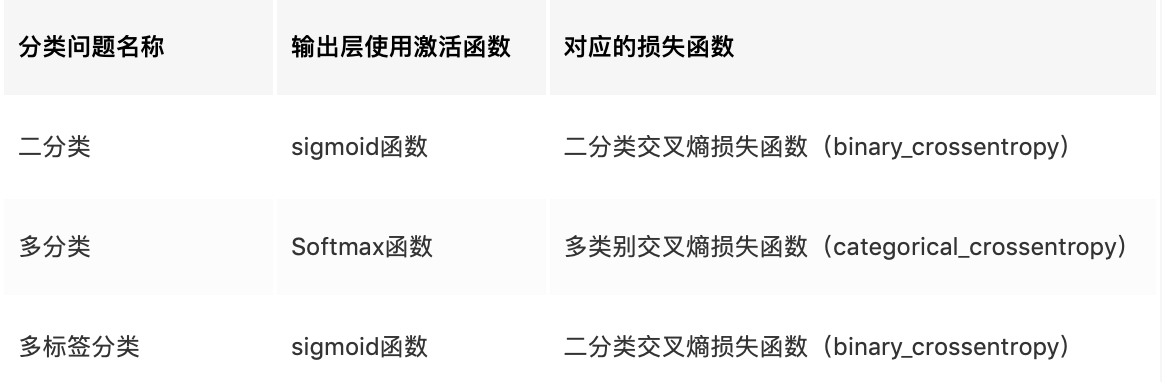

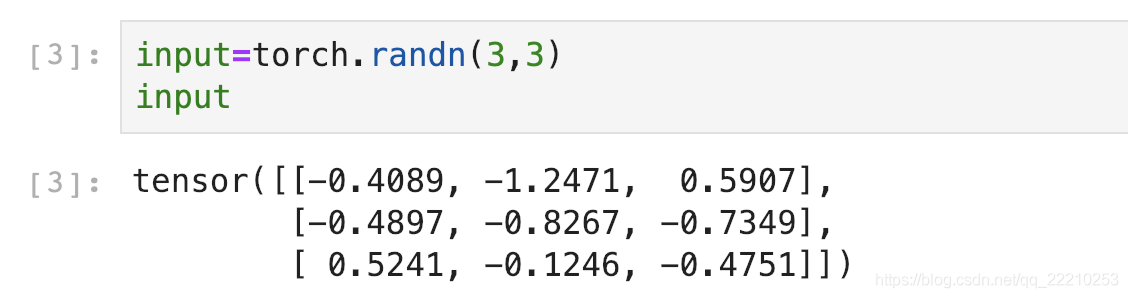

BCELoss在图片多标签分类时,如果3张图片分3类,会输出一个3*3的矩阵。先用Sigmoid给这些值都搞到0~1之间:假设Target是:下面我们用BCELoss来验证一下Loss是不是0.7194!emmm应该是我上面每次都保留4位小数,算到最后误差越来越大差了0.0001。不过也很厉害啦哈哈哈哈哈!BCEWithLogitsLossBCEWithLogitsLoss就是把Sigmoid-BCELoss合成一步。我们直接用刚刚的input验证一下是不是0.7193:嘻嘻,我可真是太厉害啦!补充:Pytorch中B...

BCELoss在图片多标签分类时,如果3张图片分3类,会输出一个3*3的矩阵。先用Sigmoid给这些值都搞到0~1之间:假设Target是:下面我们用BCELoss来验证一下Loss是不是0.7194!emmm应该是我上面每次都保留4位小数,算到最后误差越来越大差了0.0001。不过也很厉害啦哈哈哈哈哈!BCEWithLogitsLossBCEWithLogitsLoss就是把Sigmoid-BCELoss合成一步。我们直接用刚刚的input验证一下是不是0.7193:嘻嘻,我可真是太厉害啦!补充:Pytorch中B...