2021

07-17

07-17

PyTorch 实现L2正则化以及Dropout的操作

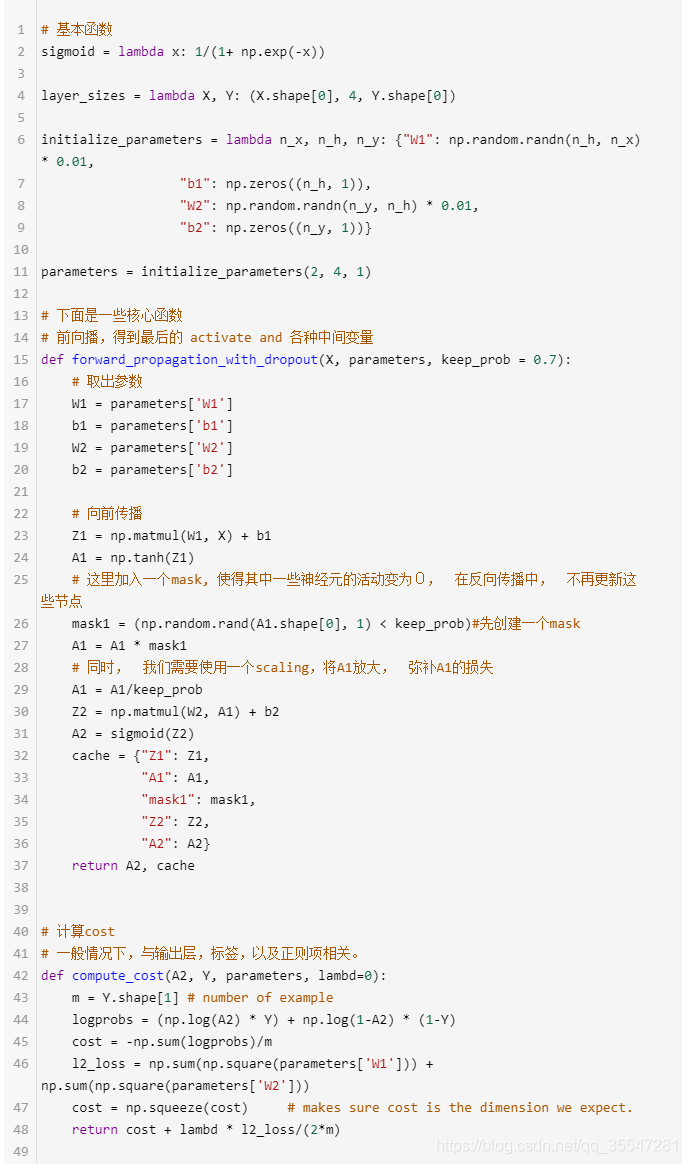

了解知道Dropout原理如果要提高神经网络的表达或分类能力,最直接的方法就是采用更深的网络和更多的神经元,复杂的网络也意味着更加容易过拟合。于是就有了Dropout,大部分实验表明其具有一定的防止过拟合的能力。用代码实现DropoutDropout的numpy实现PyTorch中实现dropoutimporttorch.nn.functionalasFimporttorch.nn.initasinitimporttorchfromtorch.autogradimportVariableimportmatplotlib.pyplotaspltimport...

继续阅读 >

了解知道Dropout原理如果要提高神经网络的表达或分类能力,最直接的方法就是采用更深的网络和更多的神经元,复杂的网络也意味着更加容易过拟合。于是就有了Dropout,大部分实验表明其具有一定的防止过拟合的能力。用代码实现DropoutDropout的numpy实现PyTorch中实现dropoutimporttorch.nn.functionalasFimporttorch.nn.initasinitimporttorchfromtorch.autogradimportVariableimportmatplotlib.pyplotaspltimport...

继续阅读 >

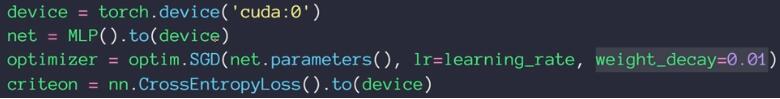

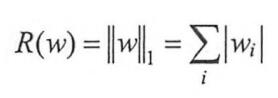

1.torch.optim优化器实现L2正则化torch.optim集成了很多优化器,如SGD,Adadelta,Adam,Adagrad,RMSprop等,这些优化器自带的一个参数weight_decay,用于指定权值衰减率,相当于L2正则化中的λ参数,注意torch.optim集成的优化器只有L2正则化方法,你可以查看注释,参数weight_decay的解析是:weight_decay(float,optional):weightdecay(L2penalty)(default:0)使用torch.optim的优化器,可如下设置L2正则化optimizer=...

1.torch.optim优化器实现L2正则化torch.optim集成了很多优化器,如SGD,Adadelta,Adam,Adagrad,RMSprop等,这些优化器自带的一个参数weight_decay,用于指定权值衰减率,相当于L2正则化中的λ参数,注意torch.optim集成的优化器只有L2正则化方法,你可以查看注释,参数weight_decay的解析是:weight_decay(float,optional):weightdecay(L2penalty)(default:0)使用torch.optim的优化器,可如下设置L2正则化optimizer=...

我就废话不多说了,大家还是直接看代码吧!model=keras.models.Sequential([#卷积层1keras.layers.Conv2D(32,kernel_size=5,strides=1,padding="same",data_format="channels_last",activation=tf.nn.relu,kernel_regularizer=keras.regularizers.l2(0.01)),#池化层1keras.layers.MaxPool2D(pool_size=2,strides=2,padding="same"),#卷积层2keras.layers.Conv2D(64,kernel_size=5,strides=1,padding="same",data_format="c...

我就废话不多说了,大家还是直接看代码吧!model=keras.models.Sequential([#卷积层1keras.layers.Conv2D(32,kernel_size=5,strides=1,padding="same",data_format="channels_last",activation=tf.nn.relu,kernel_regularizer=keras.regularizers.l2(0.01)),#池化层1keras.layers.MaxPool2D(pool_size=2,strides=2,padding="same"),#卷积层2keras.layers.Conv2D(64,kernel_size=5,strides=1,padding="same",data_format="c...