2021

08-08

08-08

pytorch 预训练模型读取修改相关参数的填坑问题

pytorch预训练模型读取修改相关参数的填坑修改部分层,仍然调用之前的模型参数。resnet=resnet50(pretrained=False)resnet.load_state_dict(torch.load(args.predir))res_conv31=Bottleneck_dilated(1024,256,dilated_rate=2)print("---------------------",res_conv31)print("---------------------",resnet.layer3[1])res_conv31.load_state_dict(resnet.layer3[1].state_dict())网络预训练模型与之前的模型对应不上,...

继续阅读 >

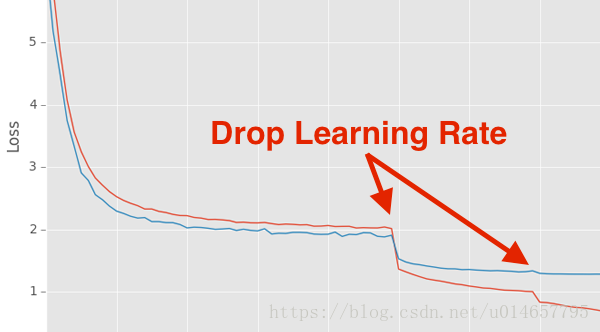

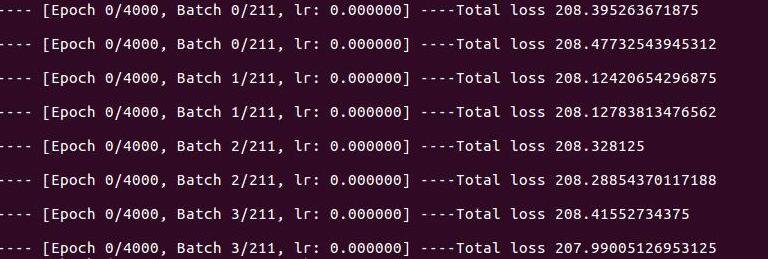

Pytorch学习率衰减及其用法学习率衰减是一个非常有效的炼丹技巧之一,在神经网络的训练过程中,当accuracy出现震荡或loss不再下降时,进行适当的学习率衰减是一个行之有效的手段,很多时候能明显提高accuracy。Pytorch中有两种学习率调整(衰减)方法:使用库函数进行调整;手动调整。1.使用库函数进行调整:Pytorch学习率调整策略通过torch.optim.lr_sheduler接口实现。pytorch提供的学习率调整策略分为三大类,分别是:(1)有...

Pytorch学习率衰减及其用法学习率衰减是一个非常有效的炼丹技巧之一,在神经网络的训练过程中,当accuracy出现震荡或loss不再下降时,进行适当的学习率衰减是一个行之有效的手段,很多时候能明显提高accuracy。Pytorch中有两种学习率调整(衰减)方法:使用库函数进行调整;手动调整。1.使用库函数进行调整:Pytorch学习率调整策略通过torch.optim.lr_sheduler接口实现。pytorch提供的学习率调整策略分为三大类,分别是:(1)有...

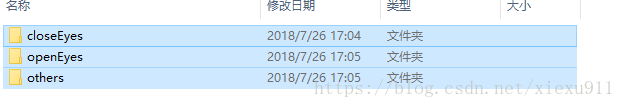

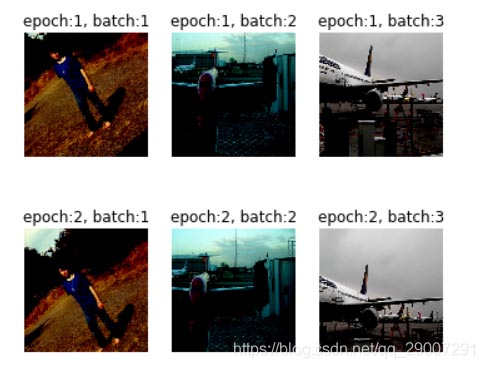

一、pytorchfinetuning自己的图片进行训练这种读取图片的方式用的是torch自带的ImageFolder,读取的文件夹必须在一个大的子文件下,按类别归好类。就像我现在要区分三个类别。#perparedataset#traindatatrain_data=torchvision.datasets.ImageFolder('F:/eyeDataSet/trainData',transform=transforms.Compose([transforms.Scale(256),transforms.CenterCrop(224),transforms.T...

一、pytorchfinetuning自己的图片进行训练这种读取图片的方式用的是torch自带的ImageFolder,读取的文件夹必须在一个大的子文件下,按类别归好类。就像我现在要区分三个类别。#perparedataset#traindatatrain_data=torchvision.datasets.ImageFolder('F:/eyeDataSet/trainData',transform=transforms.Compose([transforms.Scale(256),transforms.CenterCrop(224),transforms.T...

之一:torchvision中包含了很多预训练好的模型,这样就使得fine-tune非常容易。本文主要介绍如何fine-tunetorchvision中预训练好的模型。安装pipinstalltorchvision如何fine-tune以resnet18为例:fromtorchvisionimportmodelsfromtorchimportnnfromtorchimportoptimresnet_model=models.resnet18(pretrained=True)#pretrained设置为True,会自动下载模型所对应权重,并加载到模型中#也可以自己下载权...

之一:torchvision中包含了很多预训练好的模型,这样就使得fine-tune非常容易。本文主要介绍如何fine-tunetorchvision中预训练好的模型。安装pipinstalltorchvision如何fine-tune以resnet18为例:fromtorchvisionimportmodelsfromtorchimportnnfromtorchimportoptimresnet_model=models.resnet18(pretrained=True)#pretrained设置为True,会自动下载模型所对应权重,并加载到模型中#也可以自己下载权...

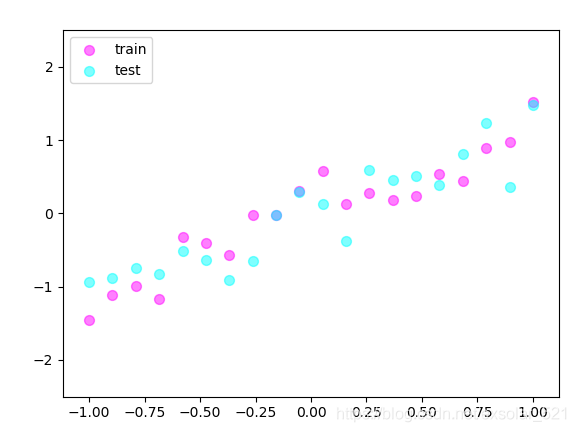

一.做数据二.搭建神经网络三.训练四.对比测试结果注意:测试过程中,一定要注意模式切换Pytorch的学习——过拟合过拟合过拟合是当数据量较小时或者输出结果过于依赖某些特定的神经元,训练神经网络训练会发生一种现象。出现这种现象的神经网络预测的结果并不具有普遍意义,其预测结果极不准确。解决方法1.增加数据量2.L1,L2,L3…正规化,即在计算误差值的时候加上要学习的参数值,当参数改变过大时,误差也会变大,通过这种惩罚...

一.做数据二.搭建神经网络三.训练四.对比测试结果注意:测试过程中,一定要注意模式切换Pytorch的学习——过拟合过拟合过拟合是当数据量较小时或者输出结果过于依赖某些特定的神经元,训练神经网络训练会发生一种现象。出现这种现象的神经网络预测的结果并不具有普遍意义,其预测结果极不准确。解决方法1.增加数据量2.L1,L2,L3…正规化,即在计算误差值的时候加上要学习的参数值,当参数改变过大时,误差也会变大,通过这种惩罚...

DDP数据shuffle的设置使用DDP要给dataloader传入sampler参数(torch.utils.data.distributed.DistributedSampler(dataset,num_replicas=None,rank=None,shuffle=True,seed=0,drop_last=False))。默认shuffle=True,但按照pytorchDistributedSampler的实现:def__iter__(self)->Iterator[T_co]:ifself.shuffle:#deterministicallyshufflebasedonepochandseedg=torch.G...

DDP数据shuffle的设置使用DDP要给dataloader传入sampler参数(torch.utils.data.distributed.DistributedSampler(dataset,num_replicas=None,rank=None,shuffle=True,seed=0,drop_last=False))。默认shuffle=True,但按照pytorchDistributedSampler的实现:def__iter__(self)->Iterator[T_co]:ifself.shuffle:#deterministicallyshufflebasedonepochandseedg=torch.G...

shuffle=False时,不打乱数据顺序shuffle=True,随机打乱importnumpyasnpimporth5pyimporttorchfromtorch.utils.dataimportDataLoader,Dataseth5f=h5py.File('train.h5','w');data1=np.array([[1,2,3],[2,5,6],[3,5,6],[4,5,6]])data2=np.array([[1,1,1],[1,2,6],[1,3,6],[1,4,6]])h5f.create_dataset(...

shuffle=False时,不打乱数据顺序shuffle=True,随机打乱importnumpyasnpimporth5pyimporttorchfromtorch.utils.dataimportDataLoader,Dataseth5f=h5py.File('train.h5','w');data1=np.array([[1,2,3],[2,5,6],[3,5,6],[4,5,6]])data2=np.array([[1,1,1],[1,2,6],[1,3,6],[1,4,6]])h5f.create_dataset(...

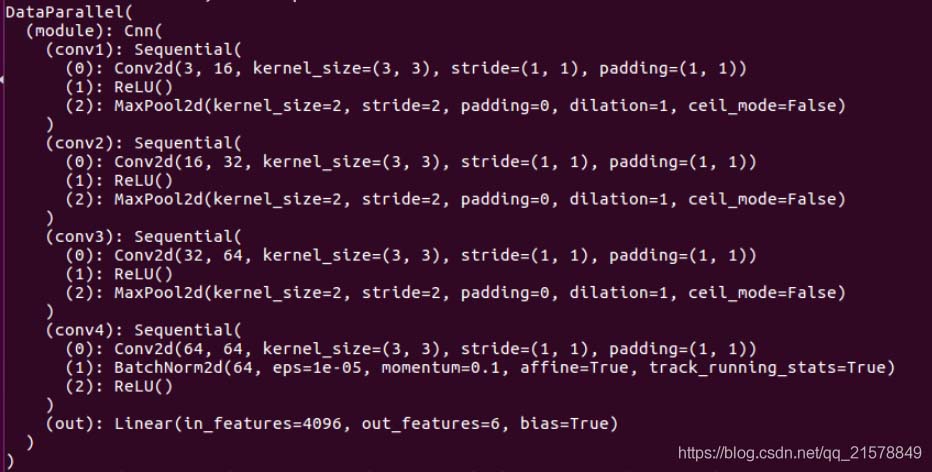

前言:最近在构建网络的时候,有一些层参数一样,于是就没有定义新的层,直接重复使用了原来已经有的层,发现效果和模型大小都没有什么变化,心中产生了疑问:定义的网络结构层能否重复使用?因此接下来利用了一个小模型网络实验了一下。一、网络结构一:(连续使用相同的层)1、网络结构如下所示:classCnn(nn.Module):def__init__(self):super(Cnn,self).__init__()self.conv1=nn.Sequential(...

前言:最近在构建网络的时候,有一些层参数一样,于是就没有定义新的层,直接重复使用了原来已经有的层,发现效果和模型大小都没有什么变化,心中产生了疑问:定义的网络结构层能否重复使用?因此接下来利用了一个小模型网络实验了一下。一、网络结构一:(连续使用相同的层)1、网络结构如下所示:classCnn(nn.Module):def__init__(self):super(Cnn,self).__init__()self.conv1=nn.Sequential(...

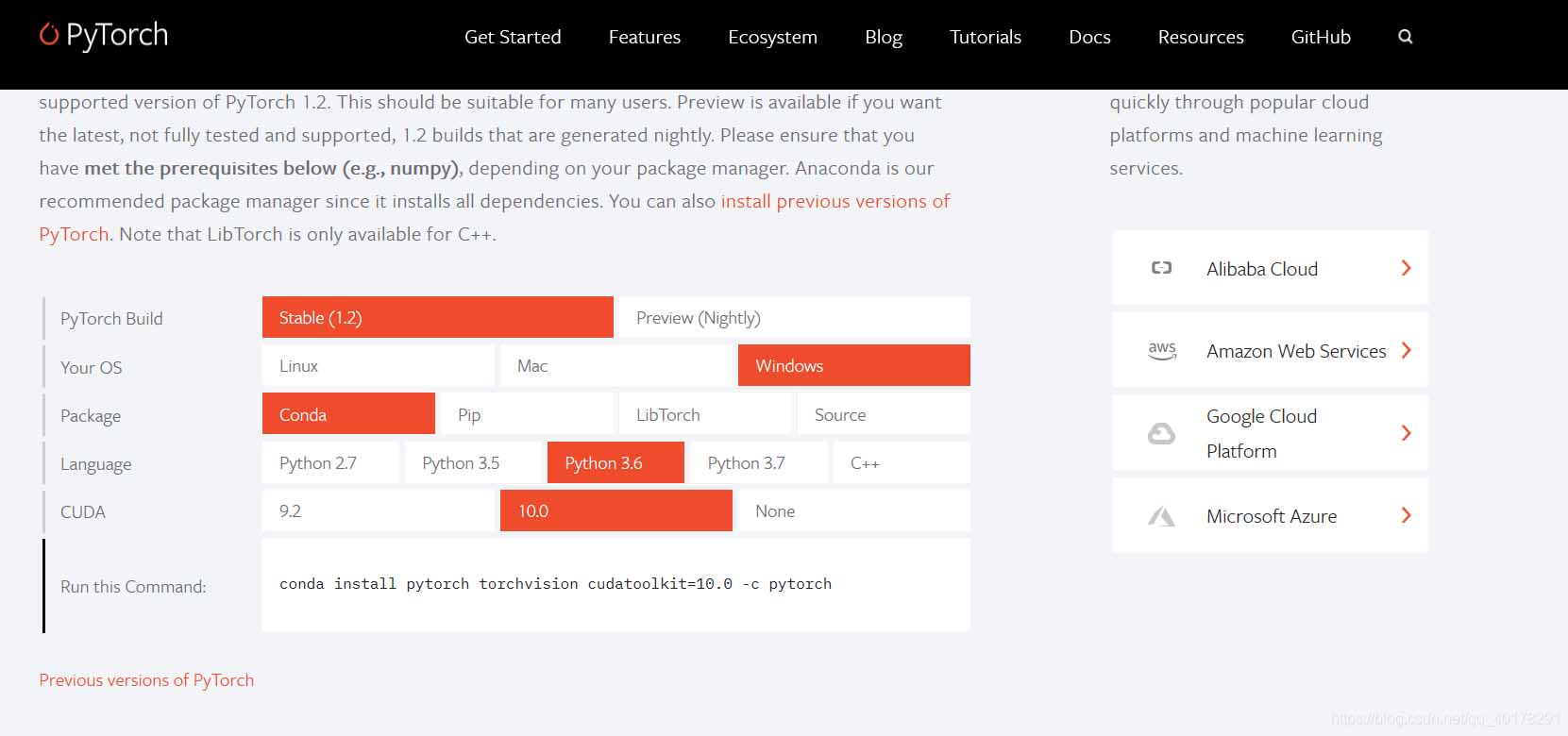

解决方法之一:如果pytorch在进行model.cuda()操作需要花费的时间很长,长到你怀疑GPU的速度了,那就是不正常的。如果你用的pytorch版本是0.3.0,升级到0.3.1就好了!.cuda()加载时间很长的其他解决方法方法一:pipinstall--upgrade--force-reinstallhttp://download.pytorch.org/whl/cu80/torch-0.2.0.post3-cp27-cp27mu-manylinux1_x86_64.whl后面这个可以自己到官网上找自己对应的python和cuda版本的安装包,官网为链接:...

解决方法之一:如果pytorch在进行model.cuda()操作需要花费的时间很长,长到你怀疑GPU的速度了,那就是不正常的。如果你用的pytorch版本是0.3.0,升级到0.3.1就好了!.cuda()加载时间很长的其他解决方法方法一:pipinstall--upgrade--force-reinstallhttp://download.pytorch.org/whl/cu80/torch-0.2.0.post3-cp27-cp27mu-manylinux1_x86_64.whl后面这个可以自己到官网上找自己对应的python和cuda版本的安装包,官网为链接:...

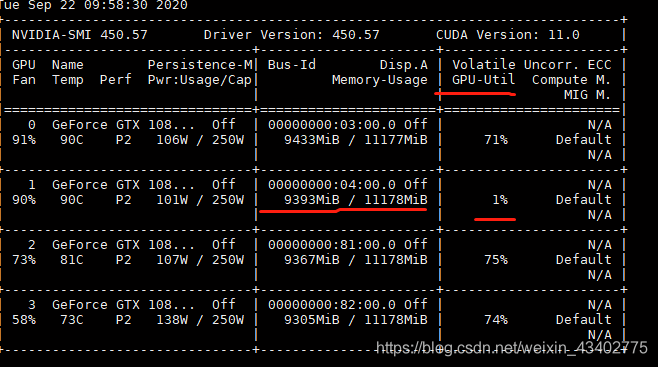

1.GPU占用率,利用率输入nvidia-smi来观察显卡的GPU内存占用率(Memory-Usage),显卡的GPU利用率(GPU-util)GPU内存占用率(Memory-Usage)往往是由于模型的大小以及batchsize的大小,来影响这个指标显卡的GPU利用率(GPU-util)往往跟代码有关,有更多的io运算,cpu运算就会导致利用率变低。比如打印loss,输出图像,等等这个时候发现,有一块卡的利用率经常跳到1%,而其他三块卡经常维持在70%以上2.原因分析当没有设置好...

1.GPU占用率,利用率输入nvidia-smi来观察显卡的GPU内存占用率(Memory-Usage),显卡的GPU利用率(GPU-util)GPU内存占用率(Memory-Usage)往往是由于模型的大小以及batchsize的大小,来影响这个指标显卡的GPU利用率(GPU-util)往往跟代码有关,有更多的io运算,cpu运算就会导致利用率变低。比如打印loss,输出图像,等等这个时候发现,有一块卡的利用率经常跳到1%,而其他三块卡经常维持在70%以上2.原因分析当没有设置好...