2021

06-23

06-23

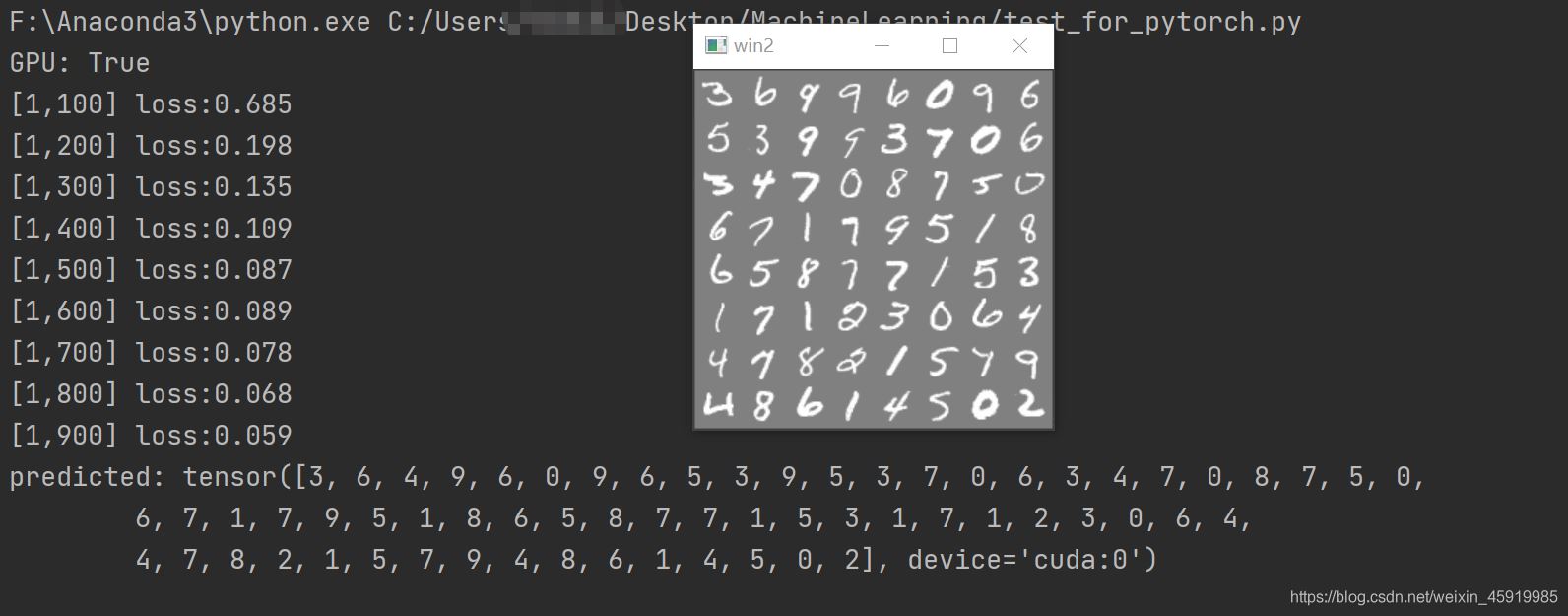

Pytorch实现图像识别之数字识别(附详细注释)

使用了两个卷积层加上两个全连接层实现本来打算从头手撕的,但是调试太耗时间了,改天有时间在从头写一份详细过程看代码注释,参考了下一个博主的文章,但是链接没注意关了找不到了,博主看到了联系下我,我加上代码相关的问题可以评论私聊,也可以翻看博客里的文章,部分有详细解释Python实现代码:importtorchimporttorch.nnasnnimporttorch.optimasoptimfromtorchvisionimportdatasets,transformsimporttorchvision...

继续阅读 >

使用了两个卷积层加上两个全连接层实现本来打算从头手撕的,但是调试太耗时间了,改天有时间在从头写一份详细过程看代码注释,参考了下一个博主的文章,但是链接没注意关了找不到了,博主看到了联系下我,我加上代码相关的问题可以评论私聊,也可以翻看博客里的文章,部分有详细解释Python实现代码:importtorchimporttorch.nnasnnimporttorch.optimasoptimfromtorchvisionimportdatasets,transformsimporttorchvision...

继续阅读 >

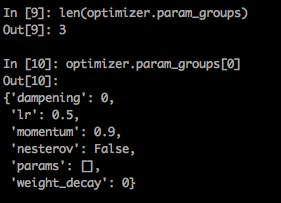

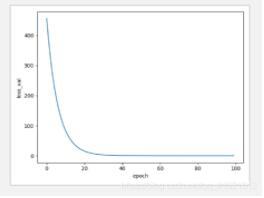

optim的基本使用fordo:1.计算loss2.清空梯度3.反传梯度4.更新参数optim的完整流程cifiron=nn.MSELoss()optimiter=torch.optim.SGD(net.parameters(),lr=0.01,momentum=0.9)foriinrange(iters):out=net(inputs)loss=cifiron(out,label)optimiter.zero_grad()#清空之前保留的梯度信息loss.backward()#将mini_batch的loss信息反传回去optimiter.step()#根据optim参数和梯度更新参...

optim的基本使用fordo:1.计算loss2.清空梯度3.反传梯度4.更新参数optim的完整流程cifiron=nn.MSELoss()optimiter=torch.optim.SGD(net.parameters(),lr=0.01,momentum=0.9)foriinrange(iters):out=net(inputs)loss=cifiron(out,label)optimiter.zero_grad()#清空之前保留的梯度信息loss.backward()#将mini_batch的loss信息反传回去optimiter.step()#根据optim参数和梯度更新参...

few-shotlearning的采样Few-shotlearning基于任务对模型进行训练,在N-way-K-shot中,一个任务中的meta-training中含有N类,每一类抽取K个样本构成supportset,queryset则是在刚才抽取的N类剩余的样本中sample一定数量的样本(可以是均匀采样,也可以是不均匀采样)。对数据按类标归类针对上述情况,我们需要使用不同类别放置在不同文件夹的数据集。但有时,数据并没有按类放置,这时就需要对数据进行处理。下面以CIFAR100为列...

few-shotlearning的采样Few-shotlearning基于任务对模型进行训练,在N-way-K-shot中,一个任务中的meta-training中含有N类,每一类抽取K个样本构成supportset,queryset则是在刚才抽取的N类剩余的样本中sample一定数量的样本(可以是均匀采样,也可以是不均匀采样)。对数据按类标归类针对上述情况,我们需要使用不同类别放置在不同文件夹的数据集。但有时,数据并没有按类放置,这时就需要对数据进行处理。下面以CIFAR100为列...

![浅谈pytorch中的nn.Sequential(*net[3: 5])是啥意思](/uploads/202105/25/16219104541.png) 看到代码里面有这个1classResNeXt101(nn.Module):2def__init__(self):3super(ResNeXt101,self).__init__()4net=resnext101()#print(os.getcwd(),net)5net=list(net.children())#net.children()得到resneXt的表层网络#fori,valueinenumerate(net):#print(i,value)6self.layer0=nn.Sequential(net[:3])#将前三层打包0,1,2两层...

看到代码里面有这个1classResNeXt101(nn.Module):2def__init__(self):3super(ResNeXt101,self).__init__()4net=resnext101()#print(os.getcwd(),net)5net=list(net.children())#net.children()得到resneXt的表层网络#fori,valueinenumerate(net):#print(i,value)6self.layer0=nn.Sequential(net[:3])#将前三层打包0,1,2两层...

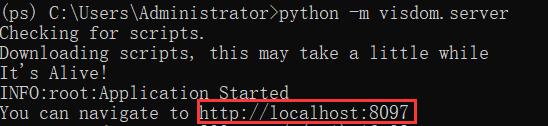

安装condaactivatepspipinstallvisdom激活ps的环境,在指定的ps环境中安装visdom开启python-mvisdom.server浏览器输入红框内的网址使用1.简单示例:一条线fromvisdomimportVisdom#创建一个实例viz=Visdom()#创建一个直线,再把最新数据添加到直线上#yx二维两个轴,win创建一个小窗口,不指定就默认为大窗口,opts其他信息比如名称viz.line([1,2,3,4],[1,2,3,4],win="train_loss",opts=dict(title='train_loss'))#...

安装condaactivatepspipinstallvisdom激活ps的环境,在指定的ps环境中安装visdom开启python-mvisdom.server浏览器输入红框内的网址使用1.简单示例:一条线fromvisdomimportVisdom#创建一个实例viz=Visdom()#创建一个直线,再把最新数据添加到直线上#yx二维两个轴,win创建一个小窗口,不指定就默认为大窗口,opts其他信息比如名称viz.line([1,2,3,4],[1,2,3,4],win="train_loss",opts=dict(title='train_loss'))#...

Pytorch版本介绍torch:1.6CUDA:10.2cuDNN:8.1.0✨安装NVIDIA显卡驱动程序一般电脑出厂/装完系统会自动安装显卡驱动如果有可直接进行下一步下载链接http://www.nvidia.cn/Download/index.aspx?lang=cn选择和自己显卡相匹配的显卡驱动下载安装✨确认项目所需torch版本#pipinstall-rrequirements.txt#base----------------------------------------Cythonmatplotlib>=3.2.2numpy>=1.18.5op...

Pytorch版本介绍torch:1.6CUDA:10.2cuDNN:8.1.0✨安装NVIDIA显卡驱动程序一般电脑出厂/装完系统会自动安装显卡驱动如果有可直接进行下一步下载链接http://www.nvidia.cn/Download/index.aspx?lang=cn选择和自己显卡相匹配的显卡驱动下载安装✨确认项目所需torch版本#pipinstall-rrequirements.txt#base----------------------------------------Cythonmatplotlib>=3.2.2numpy>=1.18.5op...

在卷积神经网络中,有使用设置padding的参数,配合卷积步长,可以使得卷积后的特征图尺寸大小不发生改变,那么在手动实现图片或特征图的边界零填充时,常用的函数是nn.ZeroPad2d(),可以指定tensor的四个方向上的填充,比如左边添加1dim、右边添加2dim、上边添加3dim、下边添加4dim,即指定paddin参数为(1,2,3,4),本文中代码设置的是(3,4,5,6)如下:importtorch.nnasnnimportcv2importtorchvisionfromtorchvision....

在卷积神经网络中,有使用设置padding的参数,配合卷积步长,可以使得卷积后的特征图尺寸大小不发生改变,那么在手动实现图片或特征图的边界零填充时,常用的函数是nn.ZeroPad2d(),可以指定tensor的四个方向上的填充,比如左边添加1dim、右边添加2dim、上边添加3dim、下边添加4dim,即指定paddin参数为(1,2,3,4),本文中代码设置的是(3,4,5,6)如下:importtorch.nnasnnimportcv2importtorchvisionfromtorchvision....

本文实例为大家分享了pytorch实现线性回归的具体代码,供大家参考,具体内容如下线性回归都是包括以下几个步骤:定义模型、选择损失函数、选择优化函数、 训练数据、测试importtorchimportmatplotlib.pyplotasplt#构建数据集x_data=torch.Tensor([[1.0],[2.0],[3.0],[4.0],[5.0],[6.0]])y_data=torch.Tensor([[2.0],[4.0],[6.0],[8.0],[10.0],[12.0]])#定义模型classLinearModel(torch.nn.Module):def__init__(s...

本文实例为大家分享了pytorch实现线性回归的具体代码,供大家参考,具体内容如下线性回归都是包括以下几个步骤:定义模型、选择损失函数、选择优化函数、 训练数据、测试importtorchimportmatplotlib.pyplotasplt#构建数据集x_data=torch.Tensor([[1.0],[2.0],[3.0],[4.0],[5.0],[6.0]])y_data=torch.Tensor([[2.0],[4.0],[6.0],[8.0],[10.0],[12.0]])#定义模型classLinearModel(torch.nn.Module):def__init__(s...

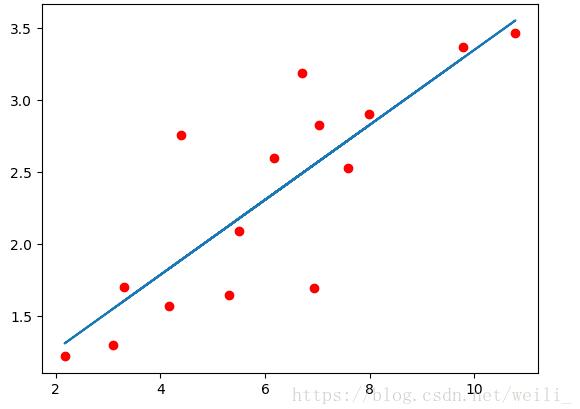

本文实例为大家分享了pytorch实现线性回归以及多元回归的具体代码,供大家参考,具体内容如下最近在学习pytorch,现在把学习的代码放在这里,下面是github链接直接附上github代码#实现一个线性回归#所有的层结构和损失函数都来自于torch.nn#torch.optim是一个实现各种优化算法的包,调用的时候必须是需要优化的参数传入,这些参数都必须是Variablex_train=np.array([[3.3],[4.4],[5.5],[6.71],[6.93],[4.168],[9.779],[6.1...

本文实例为大家分享了pytorch实现线性回归以及多元回归的具体代码,供大家参考,具体内容如下最近在学习pytorch,现在把学习的代码放在这里,下面是github链接直接附上github代码#实现一个线性回归#所有的层结构和损失函数都来自于torch.nn#torch.optim是一个实现各种优化算法的包,调用的时候必须是需要优化的参数传入,这些参数都必须是Variablex_train=np.array([[3.3],[4.4],[5.5],[6.71],[6.93],[4.168],[9.779],[6.1...

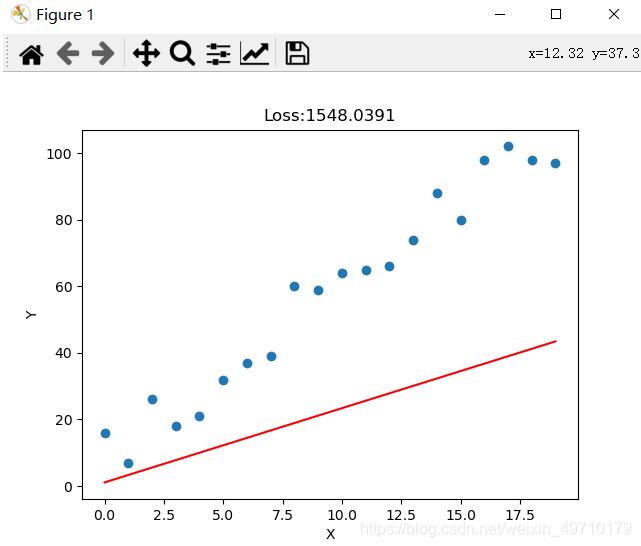

pytorch实现线性回归代码练习实例,供大家参考,具体内容如下欢迎大家指正,希望可以通过小的练习提升对于pytorch的掌握#随机初始化一个二维数据集,使用朋友torch训练一个回归模型importnumpyasnpimportrandomimportmatplotlib.pyplotaspltx=np.arange(20)y=np.array([5*x[i]+random.randint(1,20)foriinrange(len(x))])#random.randint(参数1,参数2)函数返回参数1和参数2之间的任意整数print('-'*50)#打...

pytorch实现线性回归代码练习实例,供大家参考,具体内容如下欢迎大家指正,希望可以通过小的练习提升对于pytorch的掌握#随机初始化一个二维数据集,使用朋友torch训练一个回归模型importnumpyasnpimportrandomimportmatplotlib.pyplotaspltx=np.arange(20)y=np.array([5*x[i]+random.randint(1,20)foriinrange(len(x))])#random.randint(参数1,参数2)函数返回参数1和参数2之间的任意整数print('-'*50)#打...

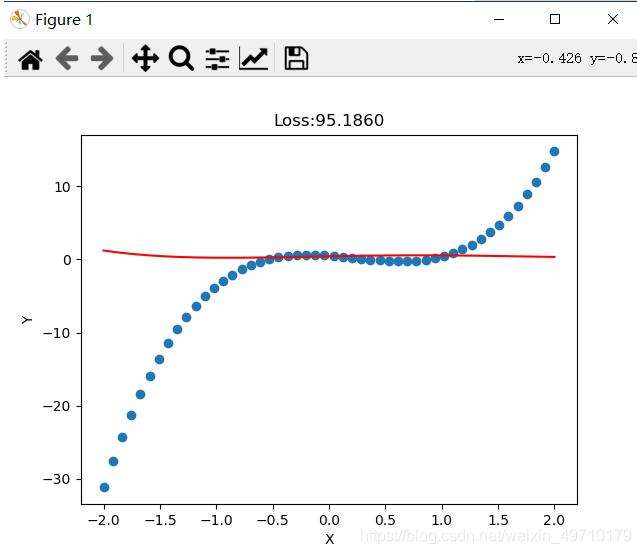

pytorch实现多项式回归,供大家参考,具体内容如下一元线性回归模型虽然能拟合出一条直线,但精度依然欠佳,拟合的直线并不能穿过每个点,对于复杂的拟合任务需要多项式回归拟合,提高精度。多项式回归拟合就是将特征的次数提高,线性回归的次数使一次的,实际我们可以使用二次、三次、四次甚至更高的次数进行拟合。由于模型的复杂度增加会带来过拟合的风险,因此需要采取正则化损失的方式减少过拟合,提高模型泛化能力。希望大家...

pytorch实现多项式回归,供大家参考,具体内容如下一元线性回归模型虽然能拟合出一条直线,但精度依然欠佳,拟合的直线并不能穿过每个点,对于复杂的拟合任务需要多项式回归拟合,提高精度。多项式回归拟合就是将特征的次数提高,线性回归的次数使一次的,实际我们可以使用二次、三次、四次甚至更高的次数进行拟合。由于模型的复杂度增加会带来过拟合的风险,因此需要采取正则化损失的方式减少过拟合,提高模型泛化能力。希望大家...

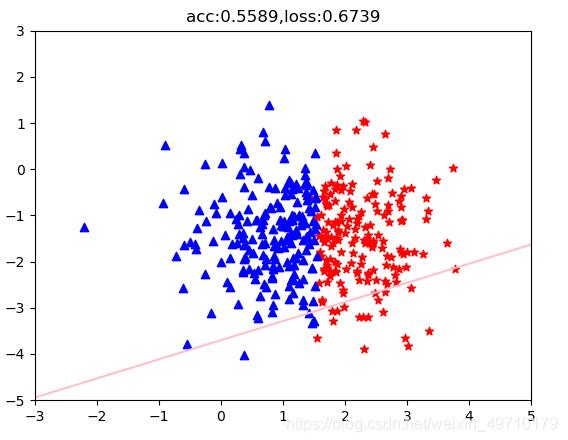

本文实例为大家分享了pytorch实现逻辑回归的具体代码,供大家参考,具体内容如下一、pytorch实现逻辑回归逻辑回归是非常经典的分类算法,是用于分类任务,如垃圾分类任务,情感分类任务等都可以使用逻辑回归。接下来使用逻辑回归模型完成一个二分类任务:#使用逻辑回归完成一个二分类任务#数据准备importtorchimportmatplotlib.pyplotaspltx1=torch.randn(365)+1.5#randn():输出一个形状为size的标准正态分布Tensorx2...

本文实例为大家分享了pytorch实现逻辑回归的具体代码,供大家参考,具体内容如下一、pytorch实现逻辑回归逻辑回归是非常经典的分类算法,是用于分类任务,如垃圾分类任务,情感分类任务等都可以使用逻辑回归。接下来使用逻辑回归模型完成一个二分类任务:#使用逻辑回归完成一个二分类任务#数据准备importtorchimportmatplotlib.pyplotaspltx1=torch.randn(365)+1.5#randn():输出一个形状为size的标准正态分布Tensorx2...

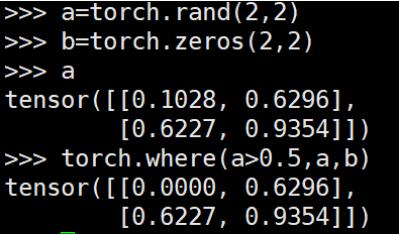

torch.where()用于将两个broadcastable的tensor组合成新的tensor,类似于c++中的三元操作符“?:”区别于pythonnumpy中的where()直接可以找到特定条件元素的index想要实现numpy中where()的功能,可以借助nonzero()对应numpy中的where()操作效果:补充:Pytorchtorch.Tensor.detach()方法的用法及修改指定模块权重的方法detachdetach的中文意思是分离,官方解释是返回一个新的Tensor,从当前的计算图中分离出来需要注意的是,返...

torch.where()用于将两个broadcastable的tensor组合成新的tensor,类似于c++中的三元操作符“?:”区别于pythonnumpy中的where()直接可以找到特定条件元素的index想要实现numpy中where()的功能,可以借助nonzero()对应numpy中的where()操作效果:补充:Pytorchtorch.Tensor.detach()方法的用法及修改指定模块权重的方法detachdetach的中文意思是分离,官方解释是返回一个新的Tensor,从当前的计算图中分离出来需要注意的是,返...