2021

08-08

08-08

Pytorch中Softmax和LogSoftmax的使用详解

一、函数解释1.Softmax函数常用的用法是指定参数dim就可以:(1)dim=0:对每一列的所有元素进行softmax运算,并使得每一列所有元素和为1。(2)dim=1:对每一行的所有元素进行softmax运算,并使得每一行所有元素和为1。classSoftmax(Module):r"""AppliestheSoftmaxfunctiontoann-dimensionalinputTensorrescalingthemsothattheelementsofthen-dimensionaloutputTensorlieintherange[0,1]and...

继续阅读 >

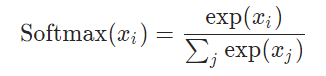

Pytorch中Softmax与LogSigmoid的对比torch.nn.Softmax作用:1、将Softmax函数应用于输入的n维Tensor,重新改变它们的规格,使n维输出张量的元素位于[0,1]范围内,并求和为1。2、返回的Tensor与原Tensor大小相同,值在[0,1]之间。3、不建议将其与NLLLoss一起使用,可以使用LogSoftmax代替之。4、Softmax的公式:参数:维度,待使用softmax计算的维度。例子:#随机初始化一个tensora=torch.randn(2,3)print(a)#输出tensor#初...

Pytorch中Softmax与LogSigmoid的对比torch.nn.Softmax作用:1、将Softmax函数应用于输入的n维Tensor,重新改变它们的规格,使n维输出张量的元素位于[0,1]范围内,并求和为1。2、返回的Tensor与原Tensor大小相同,值在[0,1]之间。3、不建议将其与NLLLoss一起使用,可以使用LogSoftmax代替之。4、Softmax的公式:参数:维度,待使用softmax计算的维度。例子:#随机初始化一个tensora=torch.randn(2,3)print(a)#输出tensor#初...

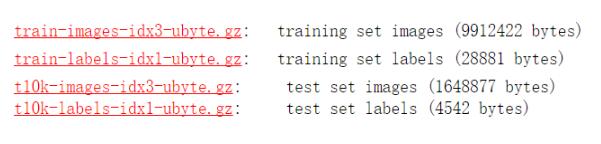

多分类一种比较常用的做法是在最后一层加softmax归一化,值最大的维度所对应的位置则作为该样本对应的类。本文采用PyTorch框架,选用经典图像数据集mnist学习一波多分类。MNIST数据集MNIST数据集(手写数字数据集)来自美国国家标准与技术研究所,NationalInstituteofStandardsandTechnology(NIST).训练集(trainingset)由来自250个不同人手写的数字构成,其中50%是高中学生,50%来自人口普查局(theCensusBureau)...

多分类一种比较常用的做法是在最后一层加softmax归一化,值最大的维度所对应的位置则作为该样本对应的类。本文采用PyTorch框架,选用经典图像数据集mnist学习一波多分类。MNIST数据集MNIST数据集(手写数字数据集)来自美国国家标准与技术研究所,NationalInstituteofStandardsandTechnology(NIST).训练集(trainingset)由来自250个不同人手写的数字构成,其中50%是高中学生,50%来自人口普查局(theCensusBureau)...