2021

11-05

11-05

Java API如何实现向Hive批量导入数据

JavaAPI实现向Hive批量导入数据Java程序中产生的数据,如果导入oracle或者mysql库,可以通过jdbc连接insert批量操作完成,但是当前版本的hive并不支持批量insert操作,因为需要先将结果数据写入hdfs文件,然后插入Hive表中。packagecom.enn.idcard;importjava.io.IOException;importjava.sql.Connection;importjava.sql.DriverManager;importjava.sql.SQLException;importjava.sql.Statement;importjava.util.ArrayList;i...

继续阅读 >

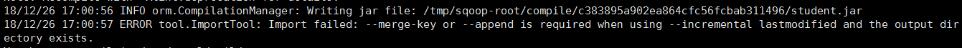

原始导数命令:bin/sqoopimport-connectjdbc:mysql://192.168.169.128:3306/yubei-usernameroot-password123456-tableyl_city_mgr_evt_info--split-byrec_id-m4--fields-terminated-by"\t"--lines-terminated-by"\n"--hive-import--hive-overwrite-create-hive-table-delete-target-dir-hive-databasedefault-hive-tableyl_city_mgr_evt_info原因分析:可能是mysql中字段里面有'\n'等分隔符,导入hive时...

原始导数命令:bin/sqoopimport-connectjdbc:mysql://192.168.169.128:3306/yubei-usernameroot-password123456-tableyl_city_mgr_evt_info--split-byrec_id-m4--fields-terminated-by"\t"--lines-terminated-by"\n"--hive-import--hive-overwrite-create-hive-table-delete-target-dir-hive-databasedefault-hive-tableyl_city_mgr_evt_info原因分析:可能是mysql中字段里面有'\n'等分隔符,导入hive时...

HiveUDFHiveUDF函数1POM文件2.UDF函数3利用idea打包4添加hiveudf函数4.1上传jar包到集群4.2修改集群hdfs文件权限4.3注册UDF4.4使用UDFHiveUDF函数1POM文件<?xmlversion="1.0"encoding="UTF-8"?><projectxmlns="http://maven.apache.org/POM/4.0.0"xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"xsi:schemaLocation="http://maven.apache.org/POM/4.0.0http://maven.apache.org/xsd/ma...

HiveUDFHiveUDF函数1POM文件2.UDF函数3利用idea打包4添加hiveudf函数4.1上传jar包到集群4.2修改集群hdfs文件权限4.3注册UDF4.4使用UDFHiveUDF函数1POM文件<?xmlversion="1.0"encoding="UTF-8"?><projectxmlns="http://maven.apache.org/POM/4.0.0"xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"xsi:schemaLocation="http://maven.apache.org/POM/4.0.0http://maven.apache.org/xsd/ma...

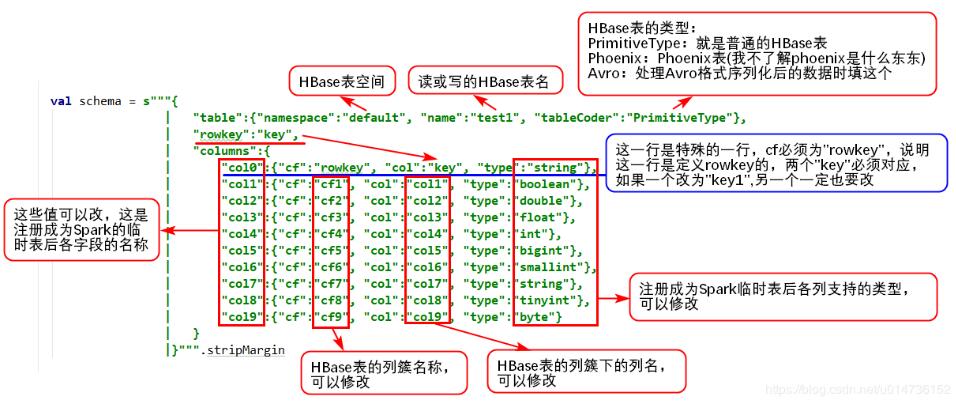

1、读Hive表数据pyspark读取hive数据非常简单,因为它有专门的接口来读取,完全不需要像hbase那样,需要做很多配置,pyspark提供的操作hive的接口,使得程序可以直接使用SQL语句从hive里面查询需要的数据,代码如下:frompyspark.sqlimportHiveContext,SparkSession_SPARK_HOST="spark://spark-master:7077"_APP_NAME="test"spark_session=SparkSession.builder.master(_SPARK_HOST).appName(_APP_NAME).getOrCreate()h...

1、读Hive表数据pyspark读取hive数据非常简单,因为它有专门的接口来读取,完全不需要像hbase那样,需要做很多配置,pyspark提供的操作hive的接口,使得程序可以直接使用SQL语句从hive里面查询需要的数据,代码如下:frompyspark.sqlimportHiveContext,SparkSession_SPARK_HOST="spark://spark-master:7077"_APP_NAME="test"spark_session=SparkSession.builder.master(_SPARK_HOST).appName(_APP_NAME).getOrCreate()h...

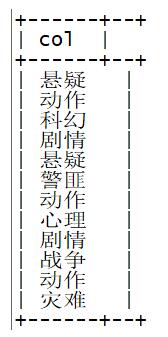

背景:加入现在有这样的数据,可能一条ocr代表两个label,并且label通过","分隔。我们想把数据转换成下面的。原始数据:labelocr日常行车服务,汽车资讯去加油站,加完油后直接离开?最开心的可能是加油站的工作人员社会民生已致2死20伤!景区突遭尘卷风袭击,孩子被卷上天!现场画面曝光目标数据:labelocr日常行车服务...

背景:加入现在有这样的数据,可能一条ocr代表两个label,并且label通过","分隔。我们想把数据转换成下面的。原始数据:labelocr日常行车服务,汽车资讯去加油站,加完油后直接离开?最开心的可能是加油站的工作人员社会民生已致2死20伤!景区突遭尘卷风袭击,孩子被卷上天!现场画面曝光目标数据:labelocr日常行车服务...

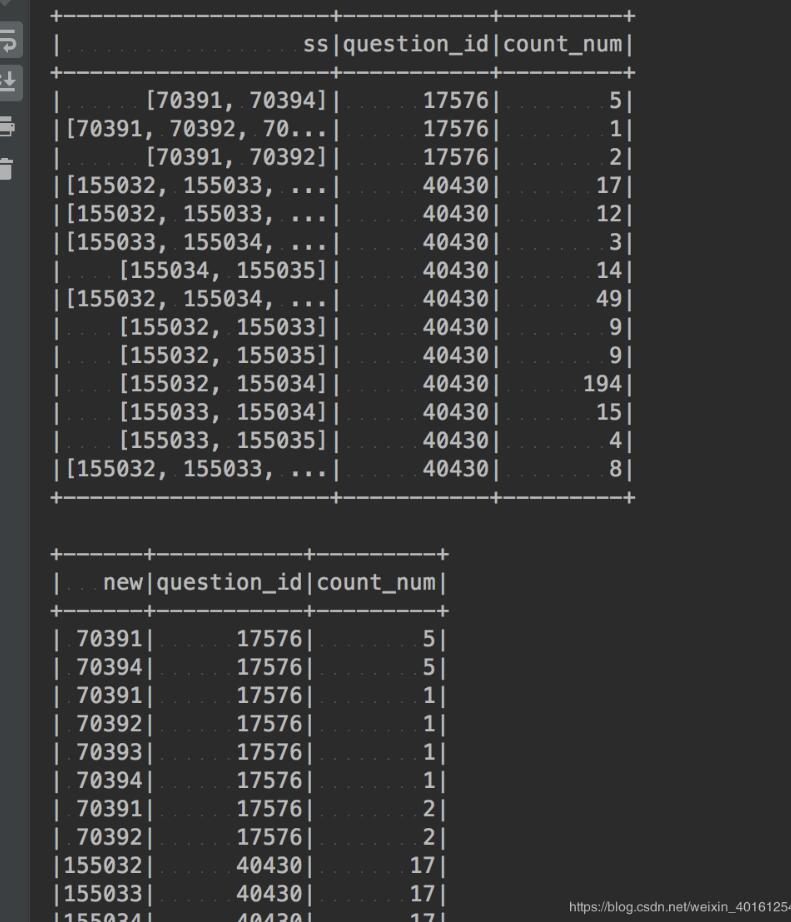

最近在工作上用到Python的pandas库来处理excel文件,遇到列转行的问题。找了一番资料后成功了,记录一下。1.如果需要爆炸的只有一列:df=pd.DataFrame({'A':[1,2],'B':[[1,2],[1,2]]})dfOut[1]:AB01[1,2]12[1,2]如果要爆炸B这一列,可以直接用explode方法(前提是你的pandas的版本要高于或等于0.25)df.explode('B')AB0111122213222.如果需要爆炸的有2列及以上df=pd.DataFrame({'A':[1,2],'B':[[1,2]...

最近在工作上用到Python的pandas库来处理excel文件,遇到列转行的问题。找了一番资料后成功了,记录一下。1.如果需要爆炸的只有一列:df=pd.DataFrame({'A':[1,2],'B':[[1,2],[1,2]]})dfOut[1]:AB01[1,2]12[1,2]如果要爆炸B这一列,可以直接用explode方法(前提是你的pandas的版本要高于或等于0.25)df.explode('B')AB0111122213222.如果需要爆炸的有2列及以上df=pd.DataFrame({'A':[1,2],'B':[[1,2]...

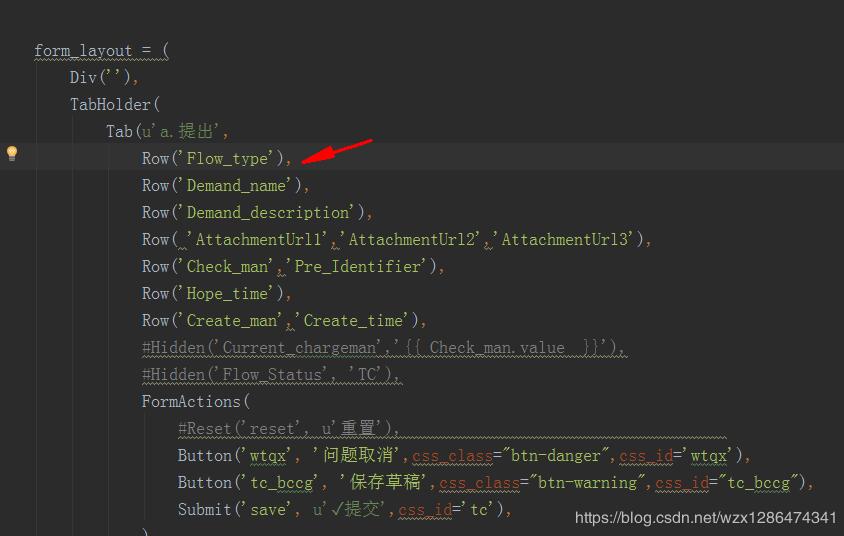

需求:用的是django的框架,想显示一个基本固定的页面,用到了form_layout上图的ROW中添加的是model中的字段名,可以显示对应的内容,如果想一行显示多个,可以写成Row('Flow_type','Demand_name'),效果如下图(图片是别人的,借鉴一下)想正常的显示,还有最后一步就是在把你需要展示的ROW中的字段,放在fields中(部分截取了一下)补充知识:xadmin编辑页隐藏字段引用xadmin的fieldSet对不想显示的字段添加**{"style":"disp...

需求:用的是django的框架,想显示一个基本固定的页面,用到了form_layout上图的ROW中添加的是model中的字段名,可以显示对应的内容,如果想一行显示多个,可以写成Row('Flow_type','Demand_name'),效果如下图(图片是别人的,借鉴一下)想正常的显示,还有最后一步就是在把你需要展示的ROW中的字段,放在fields中(部分截取了一下)补充知识:xadmin编辑页隐藏字段引用xadmin的fieldSet对不想显示的字段添加**{"style":"disp...