2021

03-09

03-09

Python jieba 中文分词与词频统计的操作

我就废话不多说了,大家还是直接看代码吧~#!python3#-*-coding:utf-8-*-importos,codecsimportjiebafromcollectionsimportCounterdefget_words(txt):seg_list=jieba.cut(txt)c=Counter()forxinseg_list:iflen(x)>1andx!='\r\n':c[x]+=1print('常用词频度统计结果')for(k,v)inc.most_common(100):print('%s%s%s%d'%(''*(5-len(k)),k,'*'*int(v/3),v))if__name__=='__main__'...

继续阅读 >

我就废话不多说了,大家还是直接看代码吧~#!python3#-*-coding:utf-8-*-importos,codecsimportjiebafromcollectionsimportCounterdefget_words(txt):seg_list=jieba.cut(txt)c=Counter()forxinseg_list:iflen(x)>1andx!='\r\n':c[x]+=1print('常用词频度统计结果')for(k,v)inc.most_common(100):print('%s%s%s%d'%(''*(5-len(k)),k,'*'*int(v/3),v))if__name__=='__main__'...

继续阅读 >

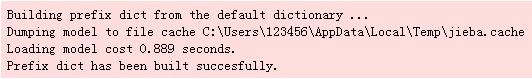

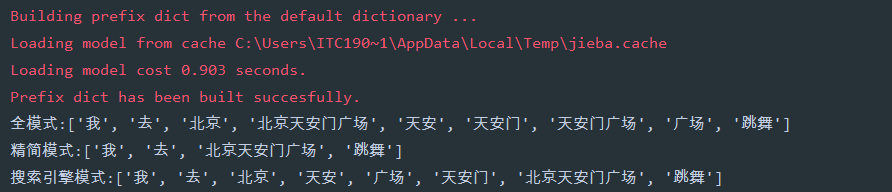

1、简要说明结巴分词支持三种分词模式,支持繁体字,支持自定义词典2、三种分词模式全模式:把句子中所有的可以成词的词语都扫描出来,速度非常快,但是不能解决歧义精简模式:把句子最精确的分开,不会添加多余单词,看起来就像是把句子分割一下搜索引擎模式:在精简模式下,对长词再度切分#-*-encoding=utf-8-*-importjiebaif__name__=='__main__':str1='我去北京天安门广场跳舞'a=jieba.lcut(str1,cut_all=True...

1、简要说明结巴分词支持三种分词模式,支持繁体字,支持自定义词典2、三种分词模式全模式:把句子中所有的可以成词的词语都扫描出来,速度非常快,但是不能解决歧义精简模式:把句子最精确的分开,不会添加多余单词,看起来就像是把句子分割一下搜索引擎模式:在精简模式下,对长词再度切分#-*-encoding=utf-8-*-importjiebaif__name__=='__main__':str1='我去北京天安门广场跳舞'a=jieba.lcut(str1,cut_all=True...

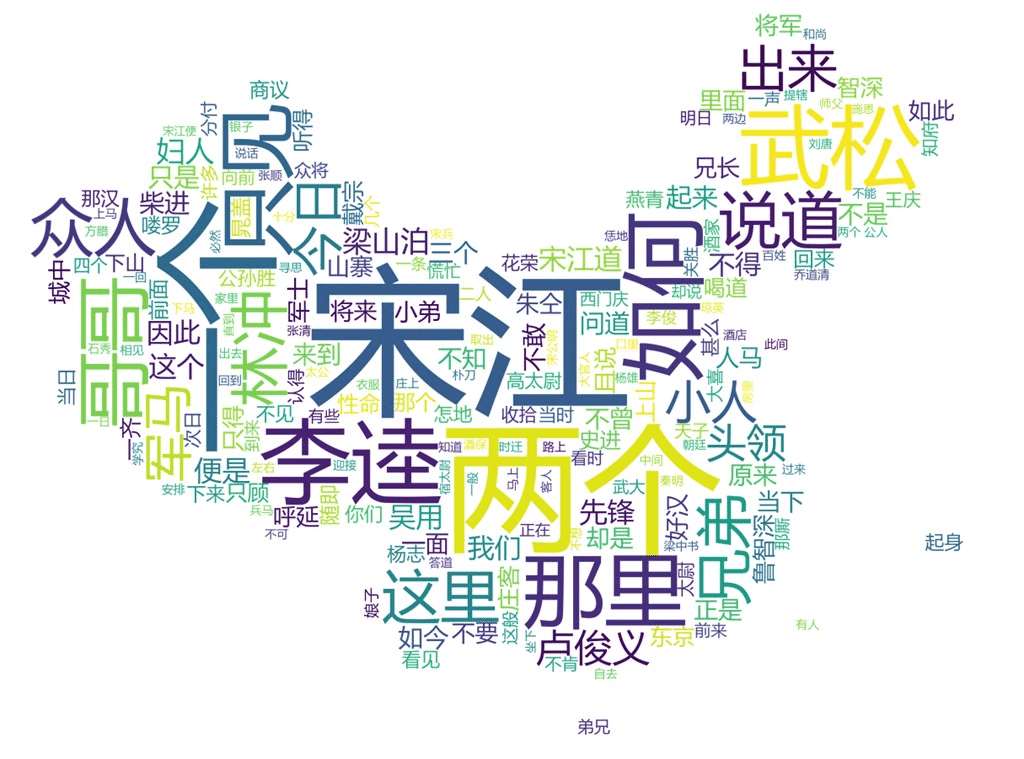

热词图很酷炫,也非常适合热点事件,抓住重点,以图文结合的方式表现出来,很有冲击力。下面这段代码是制作热词图的,用到了以下技术:jieba,把文本分词wordcloud,制作热图chardet,辨别文件的编码格式,其中中文统一为GB18030,更加的兼容imageio,提取图片的形状其他:自动识别文件编码,自动识别txt文件,图片文件名与txt文件一致,使用的是四大名著的文本(自行百度),部分中国地图上代码:importosimportjiebaimportwor...

热词图很酷炫,也非常适合热点事件,抓住重点,以图文结合的方式表现出来,很有冲击力。下面这段代码是制作热词图的,用到了以下技术:jieba,把文本分词wordcloud,制作热图chardet,辨别文件的编码格式,其中中文统一为GB18030,更加的兼容imageio,提取图片的形状其他:自动识别文件编码,自动识别txt文件,图片文件名与txt文件一致,使用的是四大名著的文本(自行百度),部分中国地图上代码:importosimportjiebaimportwor...