2021

07-09

07-09

解决pytorch中的kl divergence计算问题

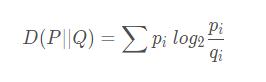

偶然从pytorch讨论论坛中看到的一个问题,KLdivergencedifferentresultsfromtf,kldivergence在TensorFlow中和pytorch中计算结果不同,平时没有注意到,记录下一篇关于KL散度、JS散度以及交叉熵对比的文章kldivergence介绍KL散度(Kullback?Leiblerdivergence),又称相对熵,是描述两个概率分布P和Q差异的一种方法。计算公式:可以发现,P和Q中元素的个数不用相等,只需要两个分布中的离散元素一致。举个简单例子...

继续阅读 >

偶然从pytorch讨论论坛中看到的一个问题,KLdivergencedifferentresultsfromtf,kldivergence在TensorFlow中和pytorch中计算结果不同,平时没有注意到,记录下一篇关于KL散度、JS散度以及交叉熵对比的文章kldivergence介绍KL散度(Kullback?Leiblerdivergence),又称相对熵,是描述两个概率分布P和Q差异的一种方法。计算公式:可以发现,P和Q中元素的个数不用相等,只需要两个分布中的离散元素一致。举个简单例子...

继续阅读 >