2021

07-12

07-12

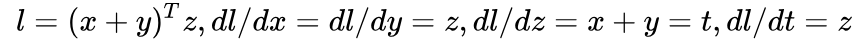

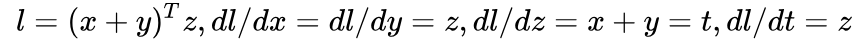

Pytorch中的backward()多个loss函数用法

Pytorch的backward()函数假若有多个loss函数,如何进行反向传播和更新呢?x=torch.tensor(2.0,requires_grad=True)y=x**2z=x#反向传播y.backward()...

继续阅读 >

Pytorch的backward()函数假若有多个loss函数,如何进行反向传播和更新呢?x=torch.tensor(2.0,requires_grad=True)y=x**2z=x#反向传播y.backward()...

继续阅读 >

PHP 代码分享

MongoDB 教程

正则表达式

jQuery 教程

JavaScript 代码片段

PHP7 教程

PHP 代码分享

MongoDB 教程

正则表达式

jQuery 教程

JavaScript 代码片段

PHP7 教程

Pytorch的backward()函数假若有多个loss函数,如何进行反向传播和更新呢?x=torch.tensor(2.0,requires_grad=True)y=x**2z=x#反向传播y.backward()...

继续阅读 >

Pytorch的backward()函数假若有多个loss函数,如何进行反向传播和更新呢?x=torch.tensor(2.0,requires_grad=True)y=x**2z=x#反向传播y.backward()...

继续阅读 >