2022

05-12

05-12

Pytorch实现张量的创建与使用方法

目录张量的创建及其基本类型1.张量(Tensor)函数创建方法2.张量的类型3.张量类型的转化张量的维度及形变1.创建高维张量2.张量的形变2.1flatten拉平:将任意维度张量转化为一维张量2.2reshape方法:任意变形特殊张量的创建方法1.特殊取值的张量的创建方法2.创建指定形状的数组张量和其他类型的转化方法张量的深拷贝张量的创建及其基本类型1.张量(Tensor)函数创建方法张量最基本的创建方法和Numpy中创建Array的格式一样,都是创建函...

继续阅读 >

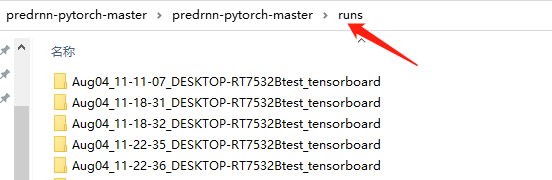

什么是TensorboardXTensorboard是TensorFlow的一个附加工具,可以记录训练过程的数字、图像等内容,以方便研究人员观察神经网络训练过程。可是对于PyTorch等其他神经网络训练框架并没有功能像Tensorboard一样全面的类似工具,一些已有的工具功能有限或使用起来比较困难(tensorboard_logger,visdom等)。TensorboardX这个工具使得TensorFlow外的其他神经网络框架也可以使用到Tensorboard的便捷功能。TensorboardX的...

什么是TensorboardXTensorboard是TensorFlow的一个附加工具,可以记录训练过程的数字、图像等内容,以方便研究人员观察神经网络训练过程。可是对于PyTorch等其他神经网络训练框架并没有功能像Tensorboard一样全面的类似工具,一些已有的工具功能有限或使用起来比较困难(tensorboard_logger,visdom等)。TensorboardX这个工具使得TensorFlow外的其他神经网络框架也可以使用到Tensorboard的便捷功能。TensorboardX的...

目录1数据 (1)导入数据(2)数据集可视化(3)为自己制作的数据集创建类(4)数据集批处理(5)数据预处理2神经网络(1)定义神经网络类(3)模型参数3最优化模型参数(1)超参数(2)损失函数(3)优化方法4模型的训练与测试(1)训练循环与测试循环(2)禁用梯度跟踪5模型的保存、导入与GPU加速(1)模型的保存与导入(2)GPU加速总结1数据 (1)导入数据我们以Fashion-MNIST数据集为例,介绍一下关于pytorch...

目录1数据 (1)导入数据(2)数据集可视化(3)为自己制作的数据集创建类(4)数据集批处理(5)数据预处理2神经网络(1)定义神经网络类(3)模型参数3最优化模型参数(1)超参数(2)损失函数(3)优化方法4模型的训练与测试(1)训练循环与测试循环(2)禁用梯度跟踪5模型的保存、导入与GPU加速(1)模型的保存与导入(2)GPU加速总结1数据 (1)导入数据我们以Fashion-MNIST数据集为例,介绍一下关于pytorch...

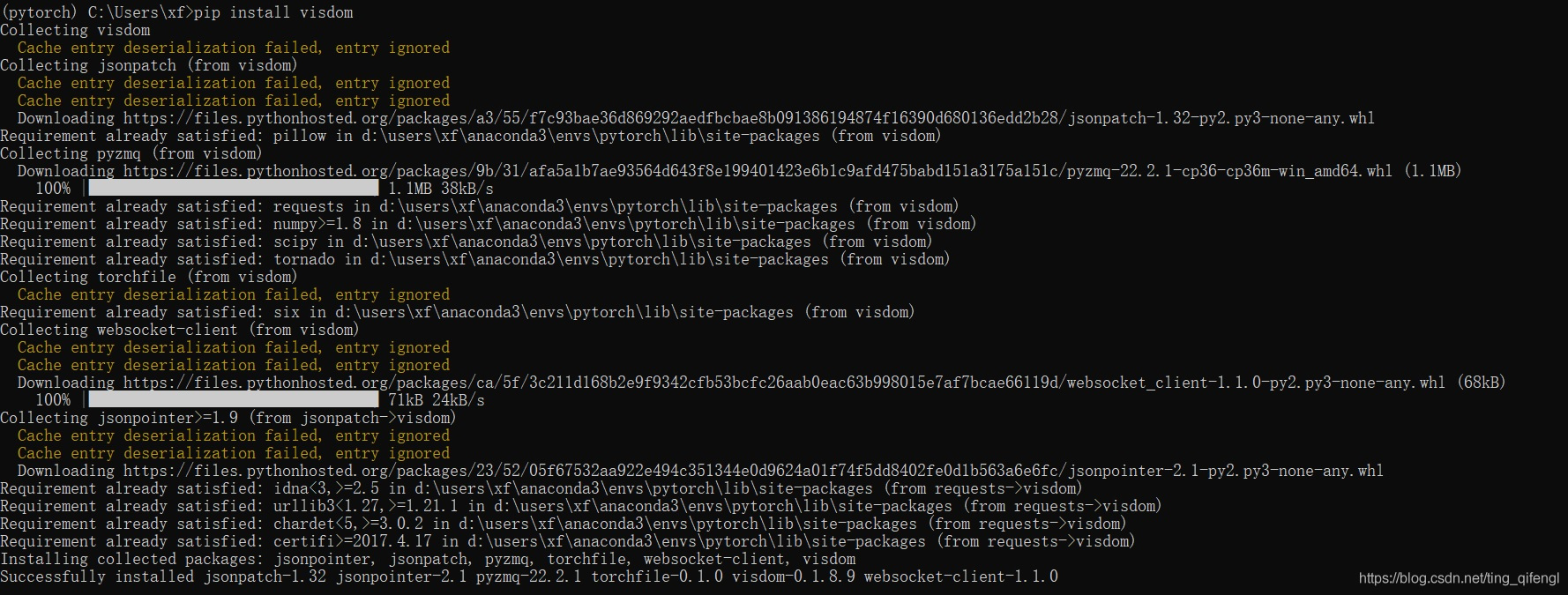

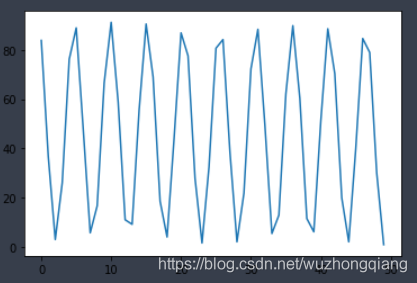

目录一、Visdom简介二、安装和运行三、可视化例子1、输出HelloWorld!2、显示图像3、绘制散点图4、绘制线条4.1绘制一条直线4.2绘制两条直线4.3绘制正弦曲线总结一、Visdom简介Visdom是由Facebook公司开发的一个进行数据可视化的Web应用程序,支持Torch、Numpy、Pytorch这3个库的创建、管理和分享实时的数据可视化结果。二、安装和运行可直接使用pip进行安装,命令如下:pipinstallvisdom安装过程如下:安装完成后,运行下面...

目录一、Visdom简介二、安装和运行三、可视化例子1、输出HelloWorld!2、显示图像3、绘制散点图4、绘制线条4.1绘制一条直线4.2绘制两条直线4.3绘制正弦曲线总结一、Visdom简介Visdom是由Facebook公司开发的一个进行数据可视化的Web应用程序,支持Torch、Numpy、Pytorch这3个库的创建、管理和分享实时的数据可视化结果。二、安装和运行可直接使用pip进行安装,命令如下:pipinstallvisdom安装过程如下:安装完成后,运行下面...

转换步骤概览准备好模型定义文件(.py文件)准备好训练完成的权重文件(.pth或.pth.tar)安装onnx和onnxruntime将训练好的模型转换为.onnx格式安装tensorRT环境参数ubuntu-18.04PyTorch-1.8.1onnx-1.9.0onnxruntime-1.7.2cuda-11.1cudnn-8.2.0TensorRT-7.2.3.4PyTorch转ONNXStep1:安装ONNX和ONNXRUNTIME网上找到的安装方式是通过pippipinstallonnxpipinstallonnxruntime如果使用的是Anaconda环境,conda...

转换步骤概览准备好模型定义文件(.py文件)准备好训练完成的权重文件(.pth或.pth.tar)安装onnx和onnxruntime将训练好的模型转换为.onnx格式安装tensorRT环境参数ubuntu-18.04PyTorch-1.8.1onnx-1.9.0onnxruntime-1.7.2cuda-11.1cudnn-8.2.0TensorRT-7.2.3.4PyTorch转ONNXStep1:安装ONNX和ONNXRUNTIME网上找到的安装方式是通过pippipinstallonnxpipinstallonnxruntime如果使用的是Anaconda环境,conda...

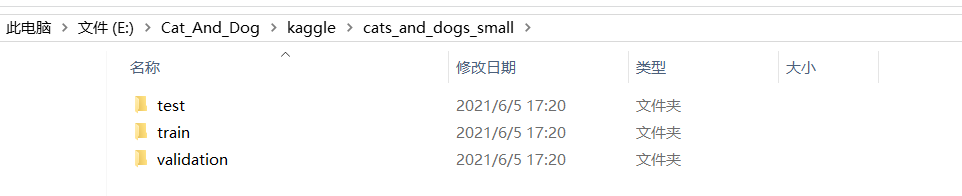

目录一、环境配置二、数据集的准备三、猫狗分类的实例四、实现分类预测测试五、参考资料一、环境配置安装Anaconda具体安装过程,请点击本文配置Pytorchpipinstall-ihttps://pypi.tuna.tsinghua.edu.cn/simpletorchpipinstall-ihttps://pypi.tuna.tsinghua.edu.cn/simpletorchvision二、数据集的准备1.数据集的下载kaggle网站的数据集下载地址:https://www.kaggle.com/lizhensheng/-20002.数据集的分类将下载的数据集进行...

目录一、环境配置二、数据集的准备三、猫狗分类的实例四、实现分类预测测试五、参考资料一、环境配置安装Anaconda具体安装过程,请点击本文配置Pytorchpipinstall-ihttps://pypi.tuna.tsinghua.edu.cn/simpletorchpipinstall-ihttps://pypi.tuna.tsinghua.edu.cn/simpletorchvision二、数据集的准备1.数据集的下载kaggle网站的数据集下载地址:https://www.kaggle.com/lizhensheng/-20002.数据集的分类将下载的数据集进行...

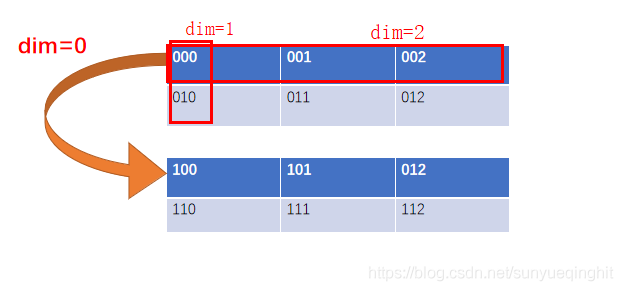

Pytorch中torch.nn.Softmax的dim参数使用含义涉及到多维tensor时,对softmax的参数dim总是很迷,下面用一个例子说明importtorch.nnasnnm=nn.Softmax(dim=0)n=nn.Softmax(dim=1)k=nn.Softmax(dim=2)input=torch.randn(2,2,3)print(input)print(m(input))print(n(input))print(k(input))输出:inputtensor([[[0.5450,-0.6264,1.0446],[0.6324,1.9069,0.7158]],[[1.0092,0.2421,-0.8928],[0.0344,0.9723,0.4...

Pytorch中torch.nn.Softmax的dim参数使用含义涉及到多维tensor时,对softmax的参数dim总是很迷,下面用一个例子说明importtorch.nnasnnm=nn.Softmax(dim=0)n=nn.Softmax(dim=1)k=nn.Softmax(dim=2)input=torch.randn(2,2,3)print(input)print(m(input))print(n(input))print(k(input))输出:inputtensor([[[0.5450,-0.6264,1.0446],[0.6324,1.9069,0.7158]],[[1.0092,0.2421,-0.8928],[0.0344,0.9723,0.4...

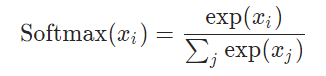

Pytorch中Softmax与LogSigmoid的对比torch.nn.Softmax作用:1、将Softmax函数应用于输入的n维Tensor,重新改变它们的规格,使n维输出张量的元素位于[0,1]范围内,并求和为1。2、返回的Tensor与原Tensor大小相同,值在[0,1]之间。3、不建议将其与NLLLoss一起使用,可以使用LogSoftmax代替之。4、Softmax的公式:参数:维度,待使用softmax计算的维度。例子:#随机初始化一个tensora=torch.randn(2,3)print(a)#输出tensor#初...

Pytorch中Softmax与LogSigmoid的对比torch.nn.Softmax作用:1、将Softmax函数应用于输入的n维Tensor,重新改变它们的规格,使n维输出张量的元素位于[0,1]范围内,并求和为1。2、返回的Tensor与原Tensor大小相同,值在[0,1]之间。3、不建议将其与NLLLoss一起使用,可以使用LogSoftmax代替之。4、Softmax的公式:参数:维度,待使用softmax计算的维度。例子:#随机初始化一个tensora=torch.randn(2,3)print(a)#输出tensor#初...

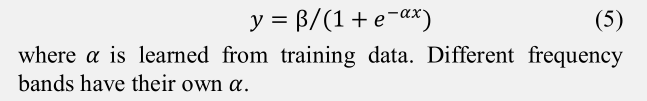

pytorch自定义不可导激活函数今天自定义不可导函数的时候遇到了一个大坑。首先我需要自定义一个函数:sign_fimporttorchfromtorch.autogradimportFunctionimporttorch.nnasnnclasssign_f(Function):@staticmethoddefforward(ctx,inputs):output=inputs.new(inputs.size())output[inputs>=0.]=1output[inputs<0.]=-1ctx.save_for_backward(inputs)returnoutp...

pytorch自定义不可导激活函数今天自定义不可导函数的时候遇到了一个大坑。首先我需要自定义一个函数:sign_fimporttorchfromtorch.autogradimportFunctionimporttorch.nnasnnclasssign_f(Function):@staticmethoddefforward(ctx,inputs):output=inputs.new(inputs.size())output[inputs>=0.]=1output[inputs<0.]=-1ctx.save_for_backward(inputs)returnoutp...

Pytorch反向传播计算梯度默认累加今天学习pytorch实现简单的线性回归,发现了pytorch的反向传播时计算梯度采用的累加机制,于是百度来一下,好多博客都说了累加机制,但是好多都没有说明这个累加机制到底会有啥影响,所以我趁着自己练习的一个例子正好直观的看一下以及如何解决:pytorch实现线性回归先附上试验代码来感受一下:torch.manual_seed(6)lr=0.01#学习率result=[]#创建训练数据x=torch.rand(20,1)*10y=...

Pytorch反向传播计算梯度默认累加今天学习pytorch实现简单的线性回归,发现了pytorch的反向传播时计算梯度采用的累加机制,于是百度来一下,好多博客都说了累加机制,但是好多都没有说明这个累加机制到底会有啥影响,所以我趁着自己练习的一个例子正好直观的看一下以及如何解决:pytorch实现线性回归先附上试验代码来感受一下:torch.manual_seed(6)lr=0.01#学习率result=[]#创建训练数据x=torch.rand(20,1)*10y=...

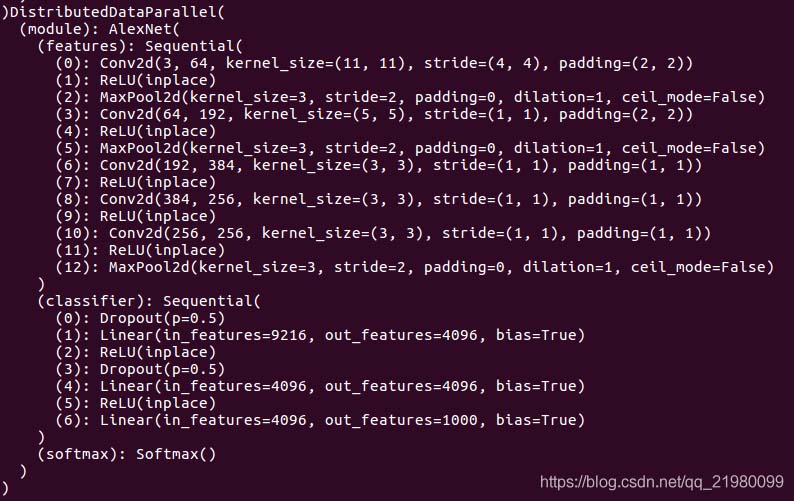

pytorch权重weight与梯度grad可视化查看特定layer的权重以及相应的梯度信息打印模型观察到model下面有module的key,module下面有features的key,features下面有(0)的key,这样就可以直接打印出weight了在pdbdebug界面输入pmodel.module.features[0].weight,就可以看到weight,输入pmodel.module.features[0].weight.grad就可以查看梯度信息。中间变量的梯度:.register_hookpytorch为了节省显存,在反向传播的过程中...

pytorch权重weight与梯度grad可视化查看特定layer的权重以及相应的梯度信息打印模型观察到model下面有module的key,module下面有features的key,features下面有(0)的key,这样就可以直接打印出weight了在pdbdebug界面输入pmodel.module.features[0].weight,就可以看到weight,输入pmodel.module.features[0].weight.grad就可以查看梯度信息。中间变量的梯度:.register_hookpytorch为了节省显存,在反向传播的过程中...

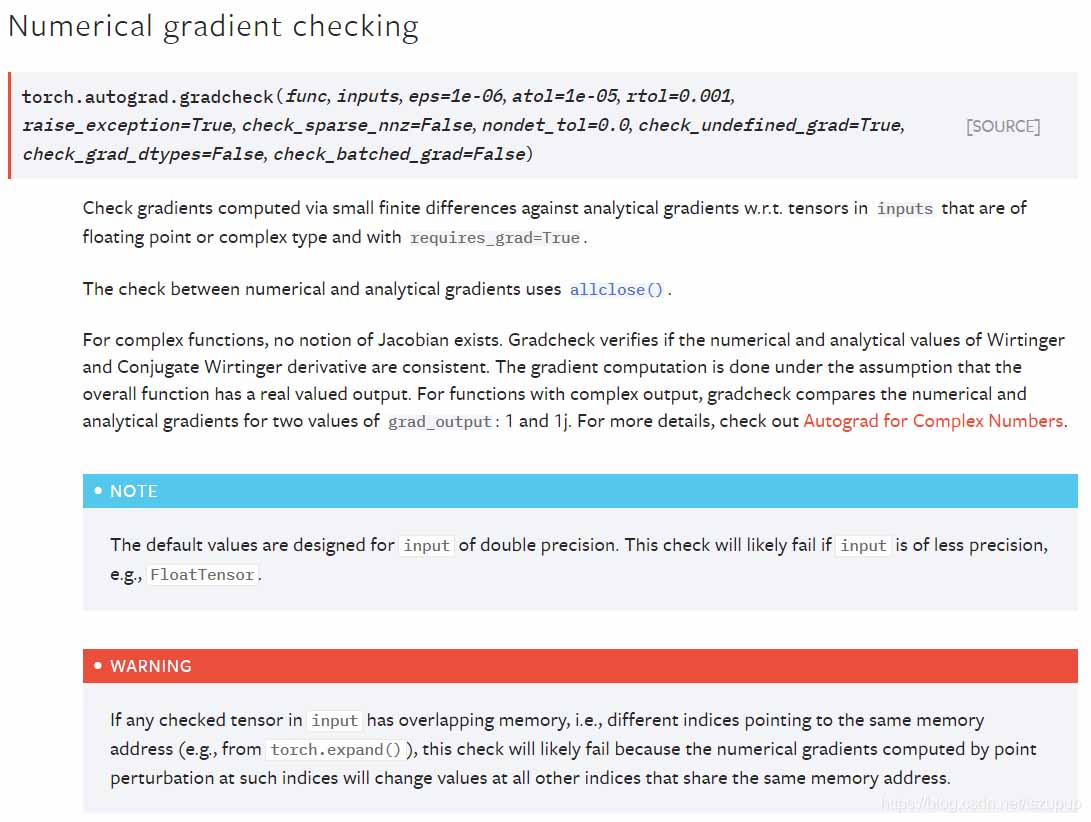

一、PyTorch检查模型梯度是否可导当我们构建复杂网络模型或在模型中加入复杂操作时,可能会需要验证该模型或操作是否可导,即模型是否能够优化,在PyTorch框架下,我们可以使用torch.autograd.gradcheck函数来实现这一功能。首先看一下官方文档中关于该函数的介绍:可以看到官方文档中介绍了该函数基于何种方法,以及其参数列表,下面给出几个例子介绍其使用方法,注意:Tensor需要是双精度浮点型且设置requires_grad=True第一...

一、PyTorch检查模型梯度是否可导当我们构建复杂网络模型或在模型中加入复杂操作时,可能会需要验证该模型或操作是否可导,即模型是否能够优化,在PyTorch框架下,我们可以使用torch.autograd.gradcheck函数来实现这一功能。首先看一下官方文档中关于该函数的介绍:可以看到官方文档中介绍了该函数基于何种方法,以及其参数列表,下面给出几个例子介绍其使用方法,注意:Tensor需要是双精度浮点型且设置requires_grad=True第一...