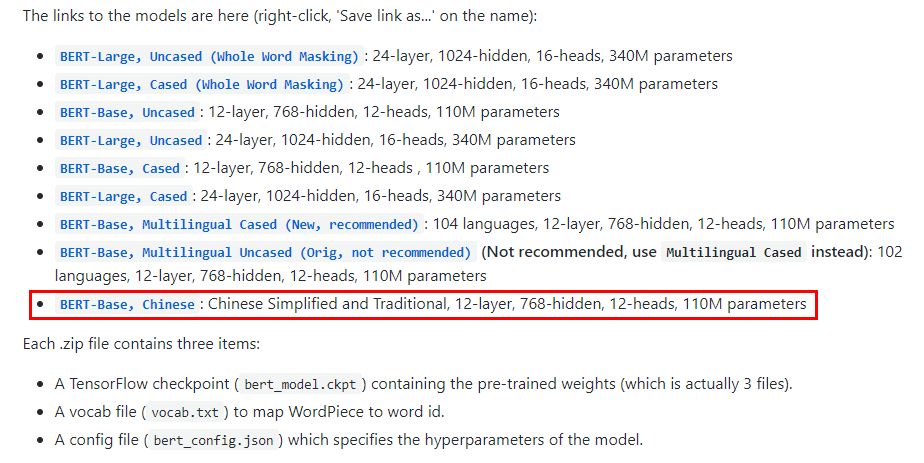

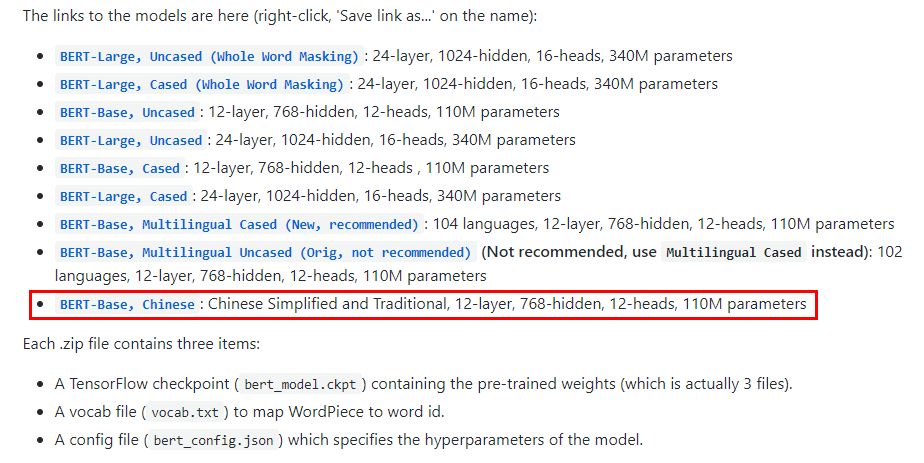

pytorch_pretrained_bert将tensorflow模型转化为pytorch模型BERT仓库里的模型是TensorFlow版本的,需要进行相应的转换才能在pytorch中使用在GoogleBERT仓库里下载需要的模型,这里使用的是中文预训练模型(chinese_L-12_H-768_A_12)下载chinese_L-12_H-768_A-12.zip后解压,里面有5个文件chinese_L-12_H-768_A-12.zip后解压,里面有5个文件bert_config.jsonbert_model.ckpt.data-00000-of-00001bert_model.ckpt.indexbert_model.ck...

继续阅读 >

pytorch_pretrained_bert将tensorflow模型转化为pytorch模型BERT仓库里的模型是TensorFlow版本的,需要进行相应的转换才能在pytorch中使用在GoogleBERT仓库里下载需要的模型,这里使用的是中文预训练模型(chinese_L-12_H-768_A_12)下载chinese_L-12_H-768_A-12.zip后解压,里面有5个文件chinese_L-12_H-768_A-12.zip后解压,里面有5个文件bert_config.jsonbert_model.ckpt.data-00000-of-00001bert_model.ckpt.indexbert_model.ck...

继续阅读 >

分类:pytorch模型

pytorch_pretrained_bert将tensorflow模型转化为pytorch模型BERT仓库里的模型是TensorFlow版本的,需要进行相应的转换才能在pytorch中使用在GoogleBERT仓库里下载需要的模型,这里使用的是中文预训练模型(chinese_L-12_H-768_A_12)下载chinese_L-12_H-768_A-12.zip后解压,里面有5个文件chinese_L-12_H-768_A-12.zip后解压,里面有5个文件bert_config.jsonbert_model.ckpt.data-00000-of-00001bert_model.ckpt.indexbert_model.ck...

继续阅读 >

pytorch_pretrained_bert将tensorflow模型转化为pytorch模型BERT仓库里的模型是TensorFlow版本的,需要进行相应的转换才能在pytorch中使用在GoogleBERT仓库里下载需要的模型,这里使用的是中文预训练模型(chinese_L-12_H-768_A_12)下载chinese_L-12_H-768_A-12.zip后解压,里面有5个文件chinese_L-12_H-768_A-12.zip后解压,里面有5个文件bert_config.jsonbert_model.ckpt.data-00000-of-00001bert_model.ckpt.indexbert_model.ck...

继续阅读 >

2021

07-30

07-30

Pytorch模型中的parameter与buffer用法

Parameter和bufferIfyouhaveparametersinyourmodel,whichshouldbesavedandrestoredinthestate_dict,butnottrainedbytheoptimizer,youshouldregisterthemasbuffers.Bufferswon'tbereturnedinmodel.parameters(),sothattheoptimizerwon'thaveachangetoupdatethem.模型中需要保存下来的参数包括两种一种是反向传播需要被optimizer更新的,称之为parameter一种是反向传播不需要被optimi...

继续阅读 >

2021

07-22

07-22

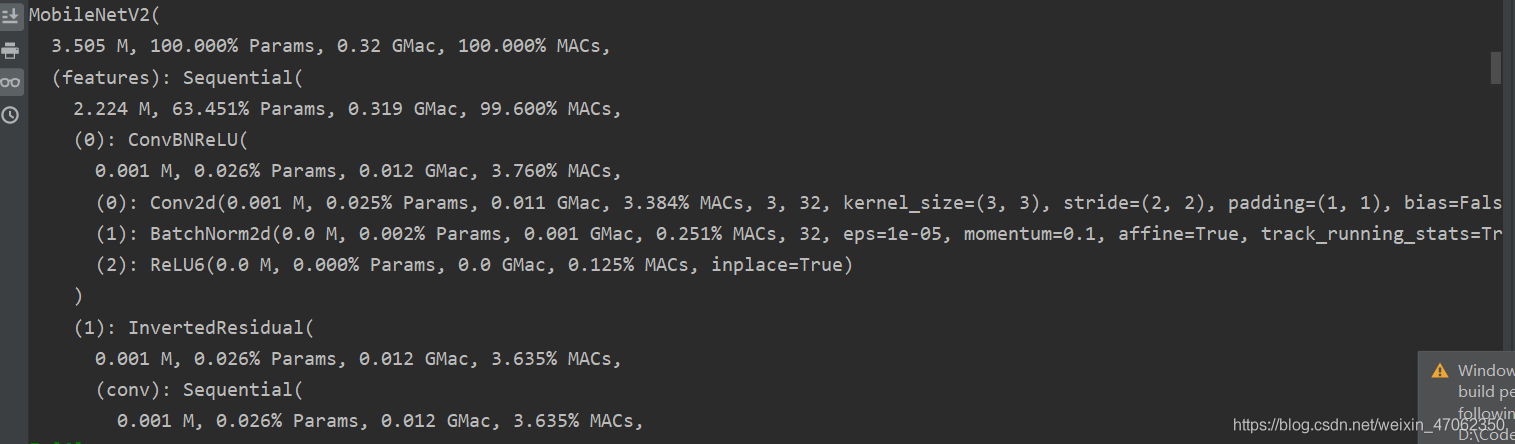

pytorch如何获得模型的计算量和参数量

方法1自带pytorch自带方法,计算模型参数总量total=sum([param.nelement()forparaminmodel.parameters()])print("Numberofparameter:%.2fM"%(total/1e6))或者total=sum(p.numel()forpinmodel.parameters())print("Totalparams:%.2fM"%(total/1e6))方法2编写代码计算模型参数总量和模型计算量defcount_params(model,input_size=224):#param_sum=0withopen('models.txt','w')asfm:f...

继续阅读 >

方法1自带pytorch自带方法,计算模型参数总量total=sum([param.nelement()forparaminmodel.parameters()])print("Numberofparameter:%.2fM"%(total/1e6))或者total=sum(p.numel()forpinmodel.parameters())print("Totalparams:%.2fM"%(total/1e6))方法2编写代码计算模型参数总量和模型计算量defcount_params(model,input_size=224):#param_sum=0withopen('models.txt','w')asfm:f...

继续阅读 >

2021

07-01

07-01

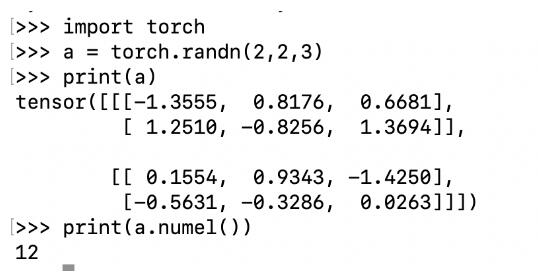

Pytorch 统计模型参数量的操作 param.numel()

param.numel()返回param中元素的数量统计模型参数量num_params=sum(param.numel()forparaminnet.parameters())print(num_params)补充:Pytorch查看模型参数Pytorch查看模型参数查看利用Pytorch搭建模型的参数,直接看程序importtorch#引入torch.nn并指定别名importtorch.nnasnnimporttorch.nn.functionalasFclassNet(nn.Module):def__init__(self):#nn.Module子类的函数必须在构造函数中执行父类的...

继续阅读 >

param.numel()返回param中元素的数量统计模型参数量num_params=sum(param.numel()forparaminnet.parameters())print(num_params)补充:Pytorch查看模型参数Pytorch查看模型参数查看利用Pytorch搭建模型的参数,直接看程序importtorch#引入torch.nn并指定别名importtorch.nnasnnimporttorch.nn.functionalasFclassNet(nn.Module):def__init__(self):#nn.Module子类的函数必须在构造函数中执行父类的...

继续阅读 >

2021

03-05

03-05

从Pytorch模型pth文件中读取参数成numpy矩阵的操作

目的:把训练好的pth模型参数提取出来,然后用其他方式部署到边缘设备。Pytorch给了很方便的读取参数接口:nn.Module.parameters()直接看demo:fromtorchvision.models.alexnetimportalexnetmodel=alexnet(pretrained=True).eval().cuda()parameters=model.parameters()forpinparameters:numpy_para=p.detach().cpu().numpy()print(type(numpy_para))print(numpy_para.shape)上面得到的numpy_para就是numpy参数...

继续阅读 >