2022

09-18

09-18

关于IDEA创建spark maven项目并连接远程spark集群问题

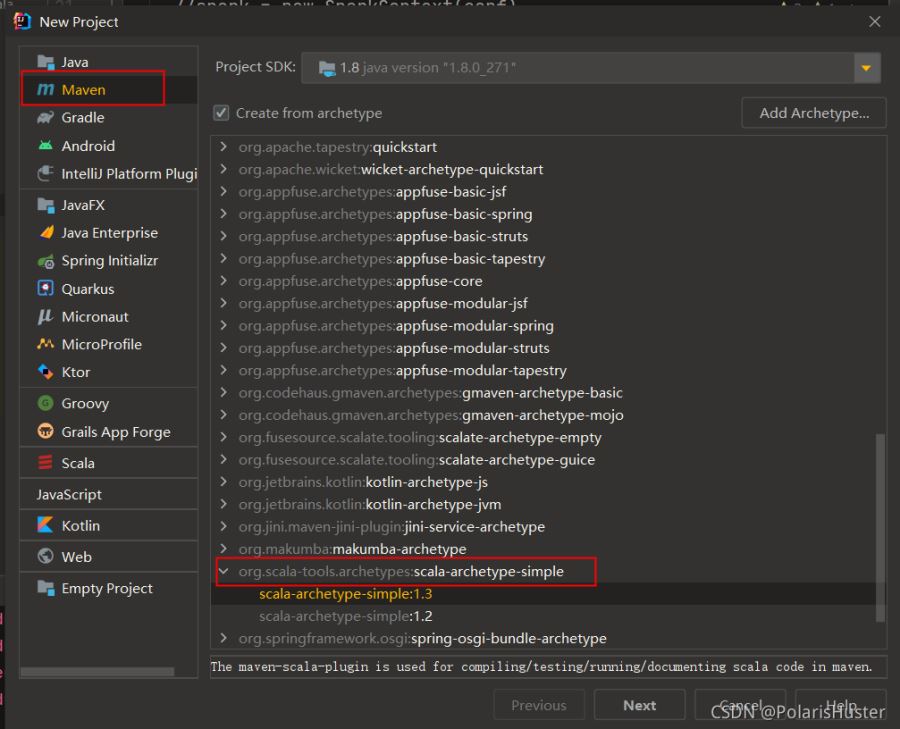

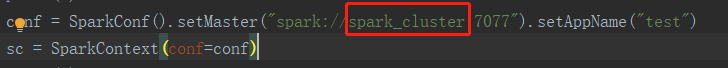

环境:scala:2.12.10spark:3.0.31、创建scalamaven项目,如下图所示:2、不同版本scala编译参数可能略有不同,笔者使用的scala版本是2.12.10,scala-archetype-simple插件生成的pom文件<plugin><groupId>org.scala-tools</groupId><artifactId>maven-scala-plugin</artifactId><version>2.15.0</version><executions><execution><goals><goal>compile</goal><goal>testCompile</goal>...

继续阅读 >

环境:scala:2.12.10spark:3.0.31、创建scalamaven项目,如下图所示:2、不同版本scala编译参数可能略有不同,笔者使用的scala版本是2.12.10,scala-archetype-simple插件生成的pom文件<plugin><groupId>org.scala-tools</groupId><artifactId>maven-scala-plugin</artifactId><version>2.15.0</version><executions><execution><goals><goal>compile</goal><goal>testCompile</goal>...

继续阅读 >

0背景由于工作需要,利用spark完成机器学习。因此需要对spark集群进行操作。所以利用pycharm和pyspark远程连接spark集群。这里记录下遇到的问题及方法。主要是参照下面的文献完成相应的内容,但是具体问题要具体分析。1方法1.1软件配置spark2.3.3,hadoop2.6,python31.2spark配置Spark集群的每个节点的Python版本必须保持一致。在每个节点的$SPARK_HOME/conf/spark-env.sh中添加一行:具体看你的安装目录。exportPYSPARK_PYT...

0背景由于工作需要,利用spark完成机器学习。因此需要对spark集群进行操作。所以利用pycharm和pyspark远程连接spark集群。这里记录下遇到的问题及方法。主要是参照下面的文献完成相应的内容,但是具体问题要具体分析。1方法1.1软件配置spark2.3.3,hadoop2.6,python31.2spark配置Spark集群的每个节点的Python版本必须保持一致。在每个节点的$SPARK_HOME/conf/spark-env.sh中添加一行:具体看你的安装目录。exportPYSPARK_PYT...

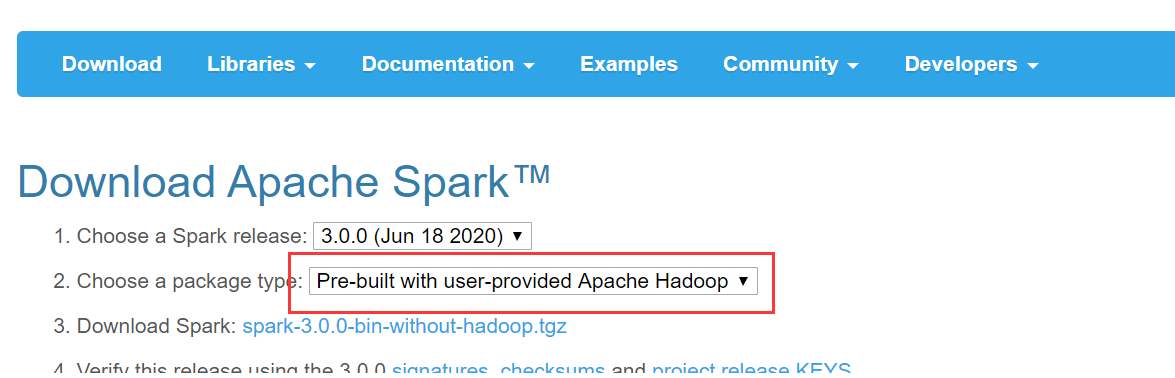

为学习spark,虚拟机中开4台虚拟机安装spark3.0.0底层hadoop集群已经安装好,见ol7.7安装部署4节点hadoop3.2.1分布式集群学习环境首先,去http://spark.apache.org/downloads.html下载对应安装包解压[hadoop@master~]$sudotar-zxfspark-3.0.0-bin-without-hadoop.tgz-C/usr/local[hadoop@master~]$cd/usr/local[hadoop@master/usr/local]$sudomv./spark-3.0.0-bin-without-hadoop/spark[hadoop@master/usr/local]...

为学习spark,虚拟机中开4台虚拟机安装spark3.0.0底层hadoop集群已经安装好,见ol7.7安装部署4节点hadoop3.2.1分布式集群学习环境首先,去http://spark.apache.org/downloads.html下载对应安装包解压[hadoop@master~]$sudotar-zxfspark-3.0.0-bin-without-hadoop.tgz-C/usr/local[hadoop@master~]$cd/usr/local[hadoop@master/usr/local]$sudomv./spark-3.0.0-bin-without-hadoop/spark[hadoop@master/usr/local]...