2021

07-17

07-17

Pytorch 如何实现常用正则化

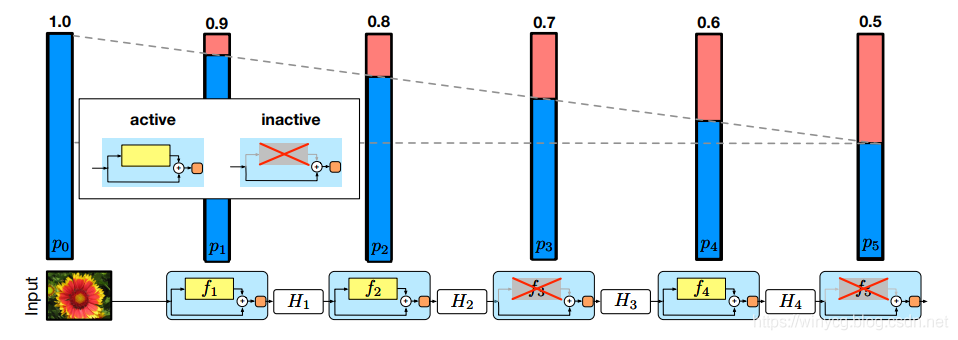

StochasticDepth论文:DeepNetworkswithStochasticDepth本文的正则化针对于ResNet中的残差结构,类似于dropout的原理,训练时对模块进行随机的删除,从而提升模型的泛化能力。对于上述的ResNet网络,模块越在后面被drop掉的概率越大。作者直觉上认为前期提取的低阶特征会被用于后面的层。第一个模块保留的概率为1,之后保留概率随着深度线性递减。对一个模块的drop函数可以采用如下的方式实现:defdrop_connect(inputs,p,t...

继续阅读 >

StochasticDepth论文:DeepNetworkswithStochasticDepth本文的正则化针对于ResNet中的残差结构,类似于dropout的原理,训练时对模块进行随机的删除,从而提升模型的泛化能力。对于上述的ResNet网络,模块越在后面被drop掉的概率越大。作者直觉上认为前期提取的低阶特征会被用于后面的层。第一个模块保留的概率为1,之后保留概率随着深度线性递减。对一个模块的drop函数可以采用如下的方式实现:defdrop_connect(inputs,p,t...

继续阅读 >