分类:PyTorch

2021

03-07

我就废话不多说了,大家还是直接看代码吧~b=torch.zeros((3,2,6,6))a=torch.zeros((3,2,1,1))a.expand_as(b).size()Out[32]:torch.Size([3,2,6,6])a=torch.zeros((3,2,2,1))a.expand_as(b).size()Traceback(mostrecentcalllast):File"/home/lart/.conda/envs/pt/lib/python3.6/site-packages/IPython/core/interactiveshell.py",line3267,inrun_codeexec(code_obj,self.user_global_ns,self.user...

继续阅读 >

2021

03-05

相当于numpy中resize()的功能,但是用法可能不太一样。我的理解是:把原先tensor中的数据按照行优先的顺序排成一个一维的数据(这里应该是因为要求地址是连续存储的),然后按照参数组合成其他维度的tensor。比如说是不管你原先的数据是[[[1,2,3],[4,5,6]]]还是[1,2,3,4,5,6],因为它们排成一维向量都是6个元素,所以只要view后面的参数一致,得到的结果都是一样的。比如,a=torch.Tensor([[[1,2,3],[4,5,6]]])b=torch.Tensor([1...

继续阅读 >

在pytorch的CNN代码中经常会看到x.view(x.size(0),-1)首先,在pytorch中的view()函数就是用来改变tensor的形状的,例如将2行3列的tensor变为1行6列,其中-1表示会自适应的调整剩余的维度a=torch.Tensor(2,3)print(a)#tensor([[0.0000,0.0000,0.0000],#[0.0000,0.0000,0.0000]])print(a.view(1,-1))#tensor([[0.0000,0.0000,0.0000,0.0000,0.0000,0.0000]])在CNN中卷积或者池化之后需要连接全连接层,所以需要把...

继续阅读 >

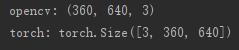

摘要:在图像识别当中,一般步骤是先读取图片,然后把图片数据转化成tensor格式,再输送到网络中去。本文将介绍如何把图片转换成tensor。一、数据转换把图片转成成torch的tensor数据,一般采用函数:torchvision.transforms。通过一个例子说明,先用opencv读取一张图片,然后在转换;注意一点是:opencv储存图片的格式和torch的储存方式不一样,opencv储存图片格式是(H,W,C),而torch储存的格式是(C,H,W)。importtorchvision....

摘要:在图像识别当中,一般步骤是先读取图片,然后把图片数据转化成tensor格式,再输送到网络中去。本文将介绍如何把图片转换成tensor。一、数据转换把图片转成成torch的tensor数据,一般采用函数:torchvision.transforms。通过一个例子说明,先用opencv读取一张图片,然后在转换;注意一点是:opencv储存图片的格式和torch的储存方式不一样,opencv储存图片格式是(H,W,C),而torch储存的格式是(C,H,W)。importtorchvision....

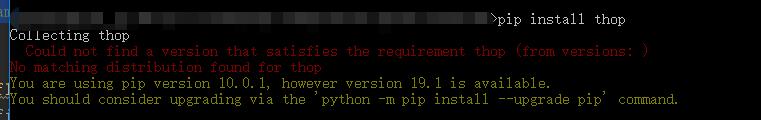

深度学习中,模型训练完后,查看模型的参数量和浮点计算量,在此记录下:1THOP在pytorch中有现成的包thop用于计算参数数量和FLOP,首先安装thop:pipinstallthop注意安装thop时可能出现如下错误:解决方法:pipinstall--upgradegit+https://github.com/Lyken17/pytorch-OpCounter.git#下载源码安装使用方法如下:fromtorchvision.modelsimportresnet50#引入ResNet50模型fromthopimportprofilemodel=resnet50()fl...

深度学习中,模型训练完后,查看模型的参数量和浮点计算量,在此记录下:1THOP在pytorch中有现成的包thop用于计算参数数量和FLOP,首先安装thop:pipinstallthop注意安装thop时可能出现如下错误:解决方法:pipinstall--upgradegit+https://github.com/Lyken17/pytorch-OpCounter.git#下载源码安装使用方法如下:fromtorchvision.modelsimportresnet50#引入ResNet50模型fromthopimportprofilemodel=resnet50()fl...

最近遇到这个函数,但查的中文博客里的解释貌似不是很到位,这里翻译一下stackoverflow上的回答并加上自己的理解。在pytorch中,只有很少几个操作是不改变tensor的内容本身,而只是重新定义下标与元素的对应关系的。换句话说,这种操作不进行数据拷贝和数据的改变,变的是元数据。这些操作是:narrow(),view(),expand()和transpose()举个栗子,在使用transpose()进行转置操作时,pytorch并不会创建新的、转置后的tensor,而是修...

最近遇到这个函数,但查的中文博客里的解释貌似不是很到位,这里翻译一下stackoverflow上的回答并加上自己的理解。在pytorch中,只有很少几个操作是不改变tensor的内容本身,而只是重新定义下标与元素的对应关系的。换句话说,这种操作不进行数据拷贝和数据的改变,变的是元数据。这些操作是:narrow(),view(),expand()和transpose()举个栗子,在使用transpose()进行转置操作时,pytorch并不会创建新的、转置后的tensor,而是修...

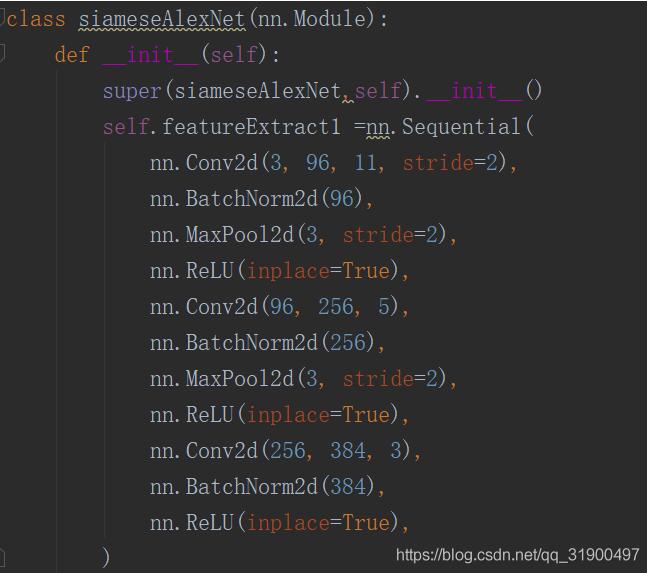

1.利用resnet18做迁移学习importtorchfromtorchvisionimportmodelsif__name__=="__main__":#device=torch.device("cuda"iftorch.cuda.is_available()else"cpu")device='cpu'print("-----device:{}".format(device))print("-----Pytorchversion:{}".format(torch.__version__))input_tensor=torch.zeros(1,3,100,100)print('input_tensor:',input_tensor.shape)pretrained_file="model/r...

1.利用resnet18做迁移学习importtorchfromtorchvisionimportmodelsif__name__=="__main__":#device=torch.device("cuda"iftorch.cuda.is_available()else"cpu")device='cpu'print("-----device:{}".format(device))print("-----Pytorchversion:{}".format(torch.__version__))input_tensor=torch.zeros(1,3,100,100)print('input_tensor:',input_tensor.shape)pretrained_file="model/r...

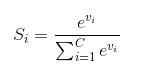

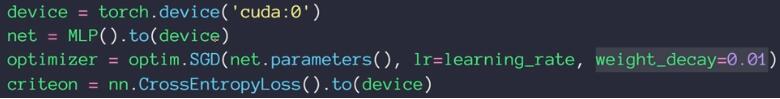

1.torch.optim优化器实现L2正则化torch.optim集成了很多优化器,如SGD,Adadelta,Adam,Adagrad,RMSprop等,这些优化器自带的一个参数weight_decay,用于指定权值衰减率,相当于L2正则化中的λ参数,注意torch.optim集成的优化器只有L2正则化方法,你可以查看注释,参数weight_decay的解析是:weight_decay(float,optional):weightdecay(L2penalty)(default:0)使用torch.optim的优化器,可如下设置L2正则化optimizer=...

1.torch.optim优化器实现L2正则化torch.optim集成了很多优化器,如SGD,Adadelta,Adam,Adagrad,RMSprop等,这些优化器自带的一个参数weight_decay,用于指定权值衰减率,相当于L2正则化中的λ参数,注意torch.optim集成的优化器只有L2正则化方法,你可以查看注释,参数weight_decay的解析是:weight_decay(float,optional):weightdecay(L2penalty)(default:0)使用torch.optim的优化器,可如下设置L2正则化optimizer=...